字节 Seed 智能体模型 UI-TARS-1.5 开源!多项 Benchmark 取得 SOTA 表现

字节 Seed 智能体模型 UI-TARS-1.5 开源!多项 Benchmark 取得 SOTA 表现

Date

2025-04-17

Category

Technology Launch

今天,我们发布并开源 UI-TARS-1.5,这是一款基于视觉-语言模型构建的开源多模态智能体,能够在虚拟世界中高效执行各类任务。

目前,UI-TARS-1.5 已在 7 个典型的 GUI 图形用户界面评测基准中取得 SOTA 表现,并首次展现了其在游戏中的长时推理能力和在开放空间中的交互能力。

GitHub:https://github.com/bytedance/UI-TARS

Website:https://seed-tars.com/

UI-TARS-1.5 基于我们此前提出的原生智能体方案 UI-TARS,通过强化学习进一步增强了模型的高阶推理能力,使模型能够在 “行动” 前先进行 “思考”。

对于推理能力的优化,显著提升了模型在面对未知环境和任务时的泛化能力,这使得 UI-TARS-1.5 在多项主流评测基准上较此前领域最优模型取得了更好表现。

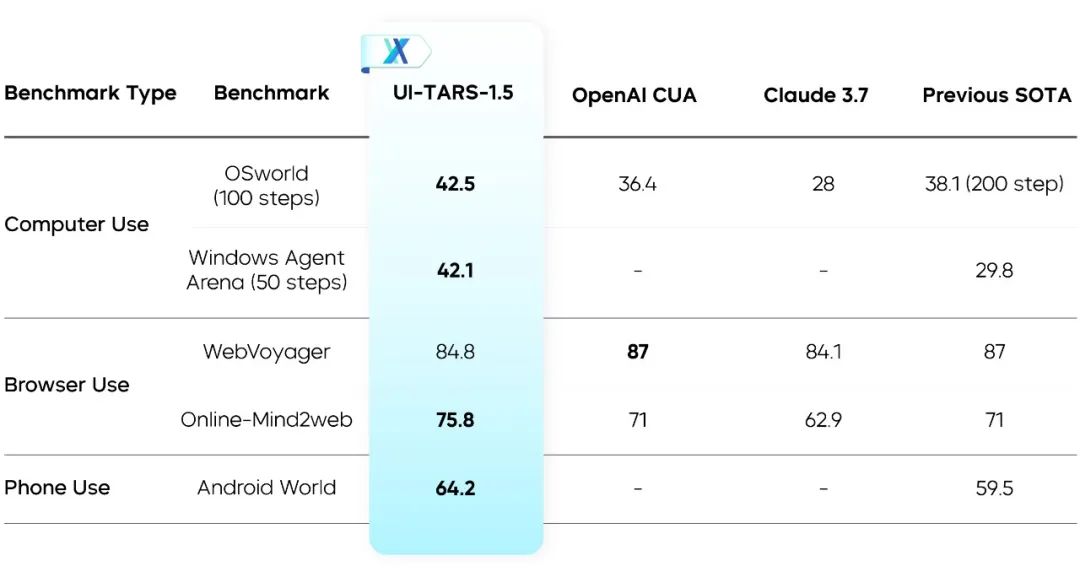

UI-TARS-1.5 在多个测评基准上的表现

此外,在 1.5 版本的模型中,我们展示了一个新的愿景:以游戏为载体来增强基础模型的推理能力。与数学、编程等领域相比,游戏更多依赖直观的、常识性的推理,并较少依赖专业知识,因此,游戏通常是评估和提升未来模型通用能力的理想测试场景。

UI-TARS-1.5 通过“思考-再行动”机制可以和人类一样“打游戏”

1. 整合强化学习能力,多项 Benchmark 取得 SOTA 表现

UI-TARS 是一个原生 GUI 智能体,具备真实操作电脑和手机系统的能力,同时,还可操控浏览器、完成复杂交互任务。

以下是 UI-TARS-1.5 的一些用例:

- Case1:帮助用户收集邮箱信息并填写表格

- Case2:识别图像内容并给文件重命名

- Case3:在浏览器上下载图片并按要求压缩

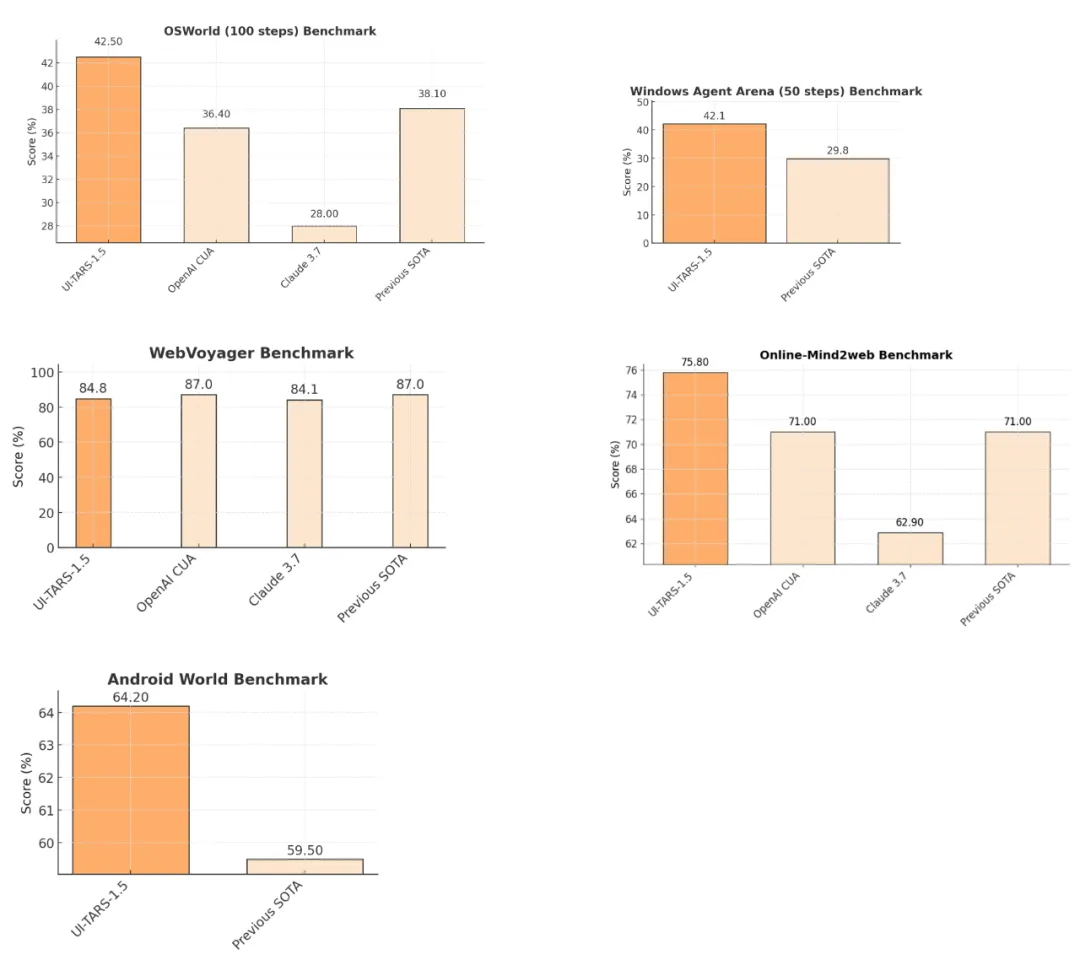

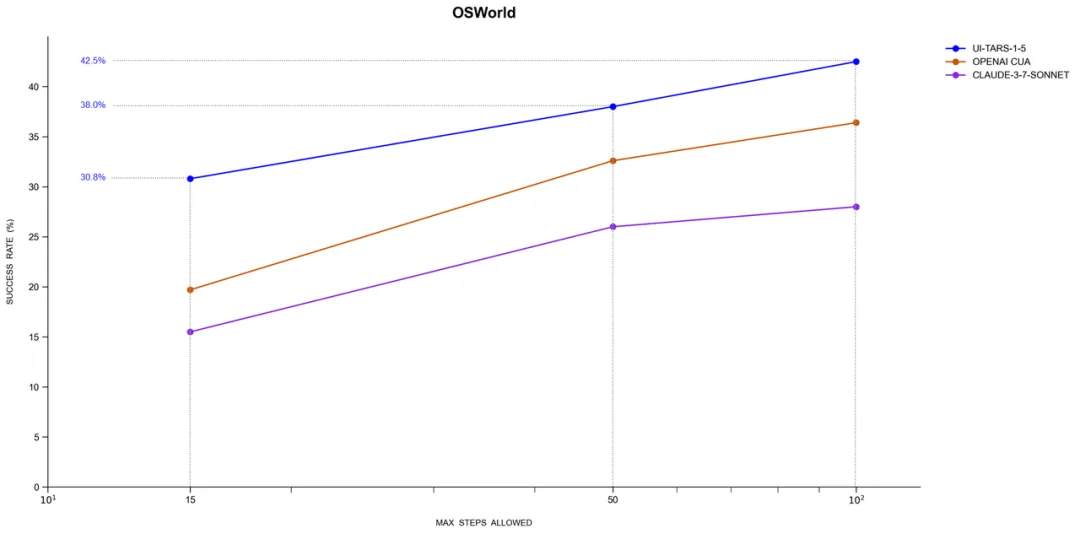

在 7 项典型 GUI 使用能力评估中,UI-TARS-1.5 均表现优异:

UI-TARS-1.5 GUI 使用能力评估

在 1.5 版本中,模型在 GUI Grounding 能力上有显著进步,这是 UI-TARS-1.5 能够完成各式复杂任务的重要基础。尤其是在高难度的 ScreenSpotPro 上,UI-TARS-1.5 的准确率为 61.6%,超过 Claude 的 27.7%、CUA 的 23.4%,以及此前领域最优模型的 43.6%。

UI-TARS-1.5 GUI Grounding 能力评估

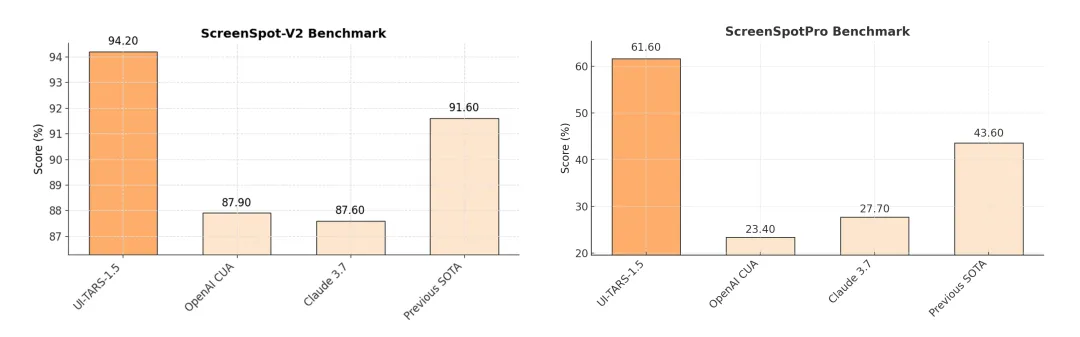

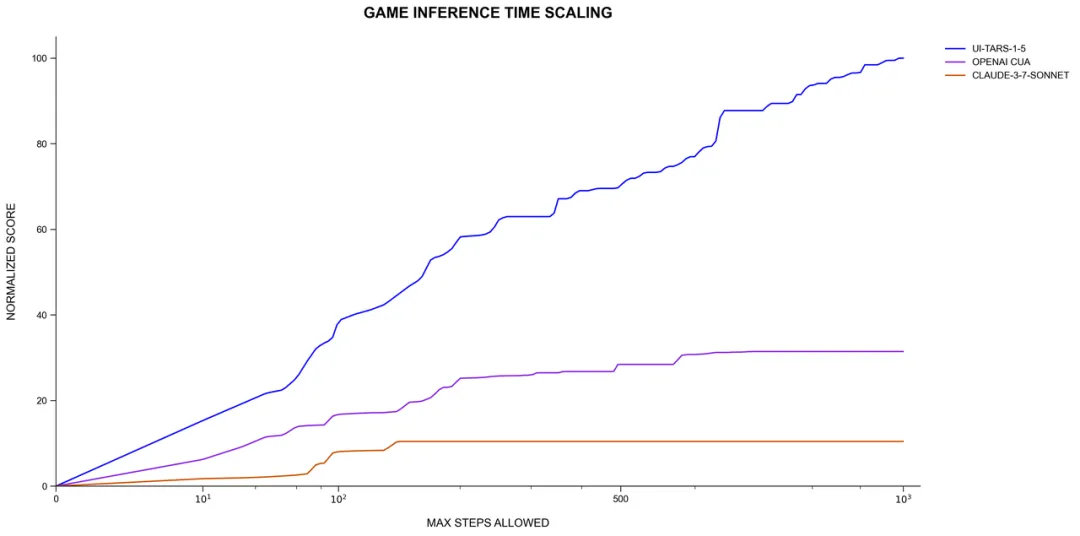

此外,我们发现 UI-TARS-1.5 在推理过程中表现出随交互轮数提升而持续增强的趋势(Inference-time Scaling),即使用越多越聪明。其稳定性与泛化能力在长程任务中更为突出。

Inference-time scaling 表现(横坐标为模型的最大步数,纵坐标为模型的性能)

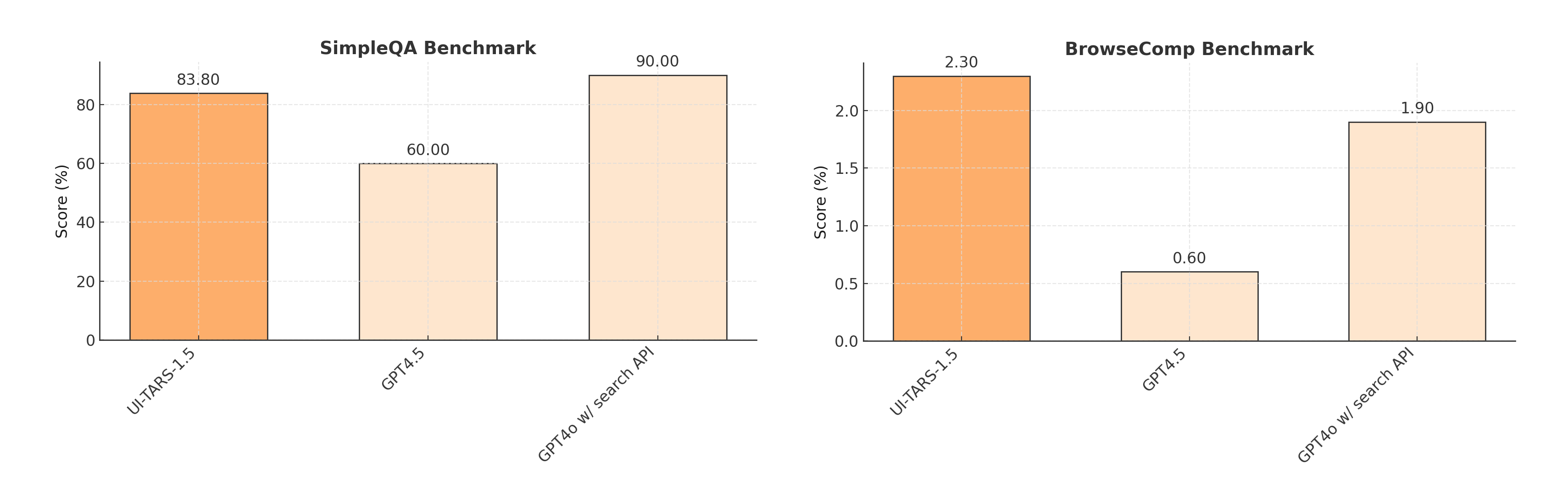

尽管 UI-TARS-1.5 并非专为信息检索类“深度研究任务”设计,但在两个具有挑战性的网页浏览任务中仍表现出较强的泛化能力,展示了作为 AI 通用界面智能体的潜力。

UI-TARS-1.5 在网页浏览任务中的表现

2. 游戏中的长时推理和 Minecraft 中的开放式交互能力

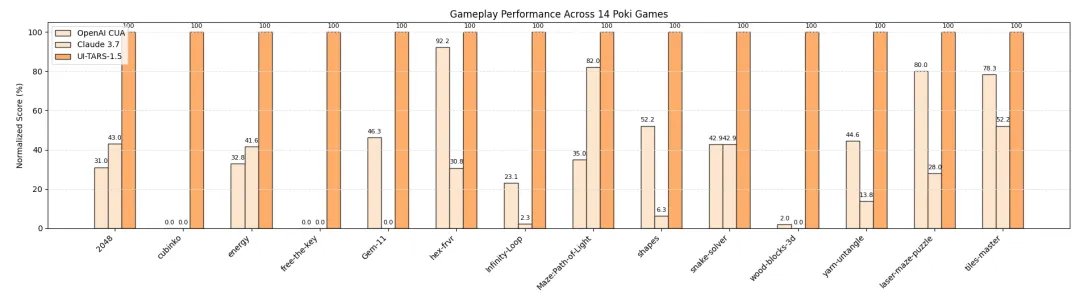

游戏任务是多模态智能体推理与策略规划能力的“试金石”。我们选取了 poki.com 上 14 款风格各异的小游戏进行测试,模型每局最多允许 1000 步交互。

案例1 Maze_Path-of-Light

案例2 Energy

案例3 Yarn-untangle

我们将每个游戏中模型的成绩归一化至 0~100,并取最高得分作为参考标准,最终平均生成总分。

UI-TARS-1.5 在多个游戏中的得分表现

UI-TARS-1.5 在游戏任务中不仅展现了较好表现,也呈现出稳定的推断时扩展性。

UI-TARS-1.5 的推断时拓展能力

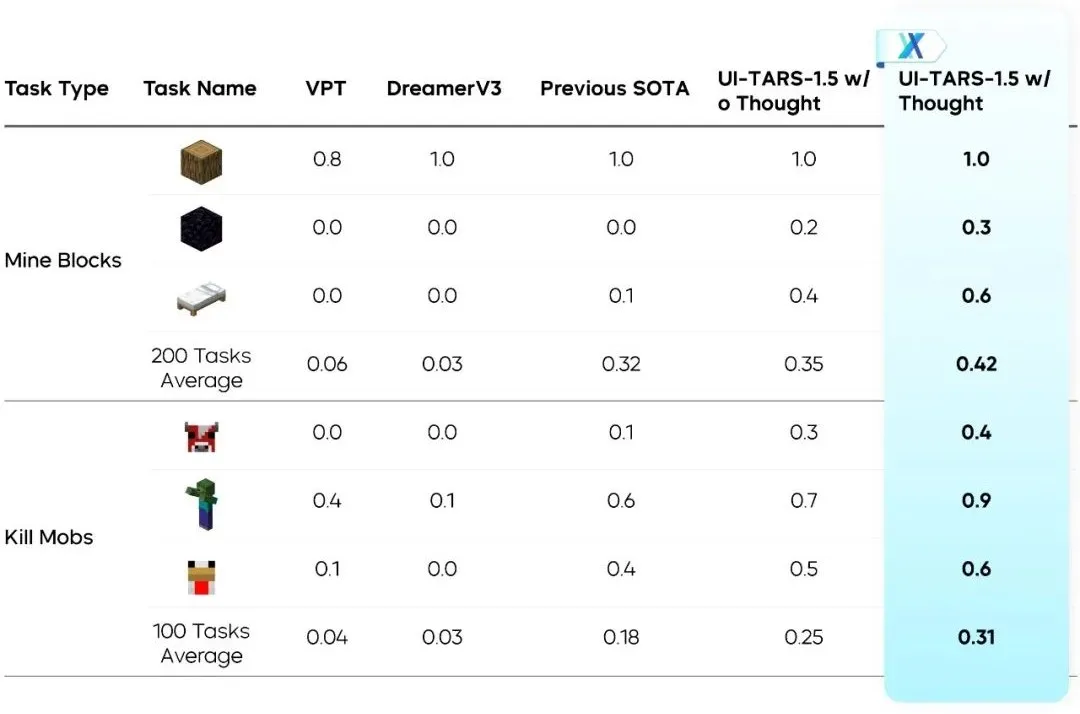

我们进一步在开放环境 Minecraft《我的世界》游戏中评估了 UI-TARS-1.5 的能力。不同于静态 GUI 评测,Minecraft 要求模型在动态三维空间中基于视觉输入进行实时决策操作。

案例1

案例2

我们采用 MineRL(v1.16.5) 标准评测任务,比较了 UI-TARS-1.5 与 OpenAI VPT、DeepMind DreamerV3、JARVIS-VLA 等主流智能体在两个任务中的表现:

- Mine Blocks: 寻找并破坏特定方块

- Kill Mobs: 搜索并击败敌对生物

所有模型均在相同条件下运行:仅使用视觉输入(无状态信息)、原生键鼠操作、第一人称视角。

UI-TARS-1.5 在 MineRL 中的测评表现

UI-TARS-1.5 在两个任务中均取得最高成功率,特别是在启用“思考模块”后表现更加突出,验证了我们所提出的“思考-再行动”机制的有效性。

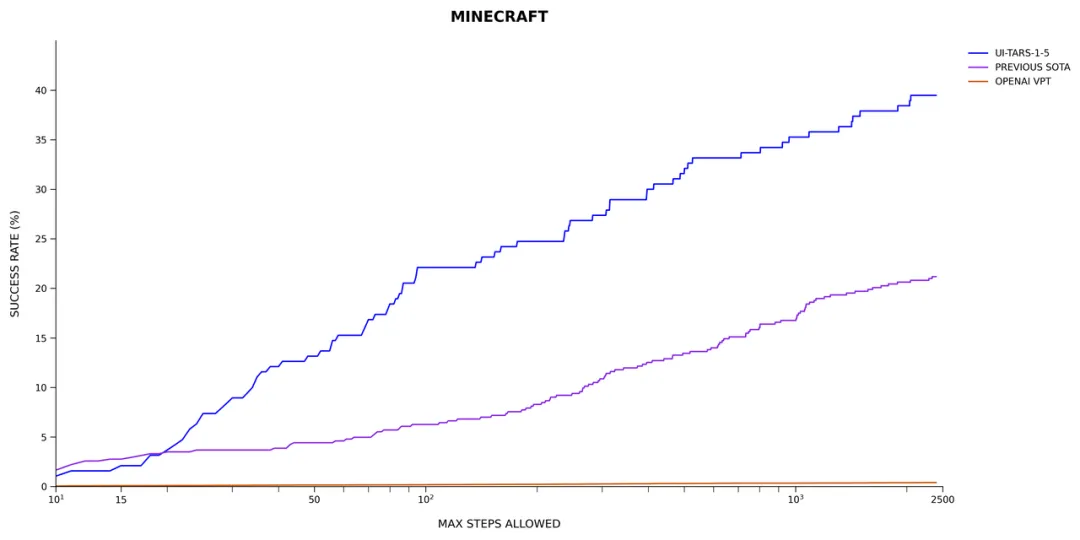

同样地,UI-TARS-1.5 在 Minecraft 中也展现出良好的扩展趋势:随着交互轮次的增加,模型的任务完成效果持续提升。它能够在交互过程中不断优化自身策略,并利用以往经验指导后续决策。

UI-TARS-1.5 在 Minecraft 中的拓展能力

3. UI-TARS-1.5 背后:先“思考”再“行动”的原生智能体模型

UI-TARS-1.5 能够实现精准 GUI 操作,基于团队在四个维度的技术探索:

- 视觉感知增强:依托大规模界面截图数据,模型可理解元素的语义与上下文,形成精准描述。

- System 2 推理机制:在动作前生成“思维(thought)”,支持复杂任务的多步规划与决策。

- 统一动作建模:构建跨平台标准动作空间,通过真实轨迹学习提升动作可控性与执行精度。

- 可自我演化的训练范式:通过自动化的交互轨迹采集与反思式训练,模型持续从错误中改进,适应复杂环境变化。

通用大模型在 GUI 场景中常面临“操作粒度不够细”“目标对齐不明确”等瓶颈,而 UI-TARS 通过视觉-动作联合优化,有效填补了这一空白。

例如,用户想让模型“把字体调大”,通用模型往往理解模糊、操作失误,而 UI-TARS 能迅速定位“设置”入口,并基于既有知识推理出正确路径,精准完成操作。

相比业界其他智能体,除了依靠视觉能力与强化学习配合完成任务, UI-TARS 还在推理与动作之间加了一道“思考”的桥梁,使得行为逻辑更连贯、响应更可靠。

在技术探索过程中,UI-TARS 团队对智能体的发展演变还有如下思考:

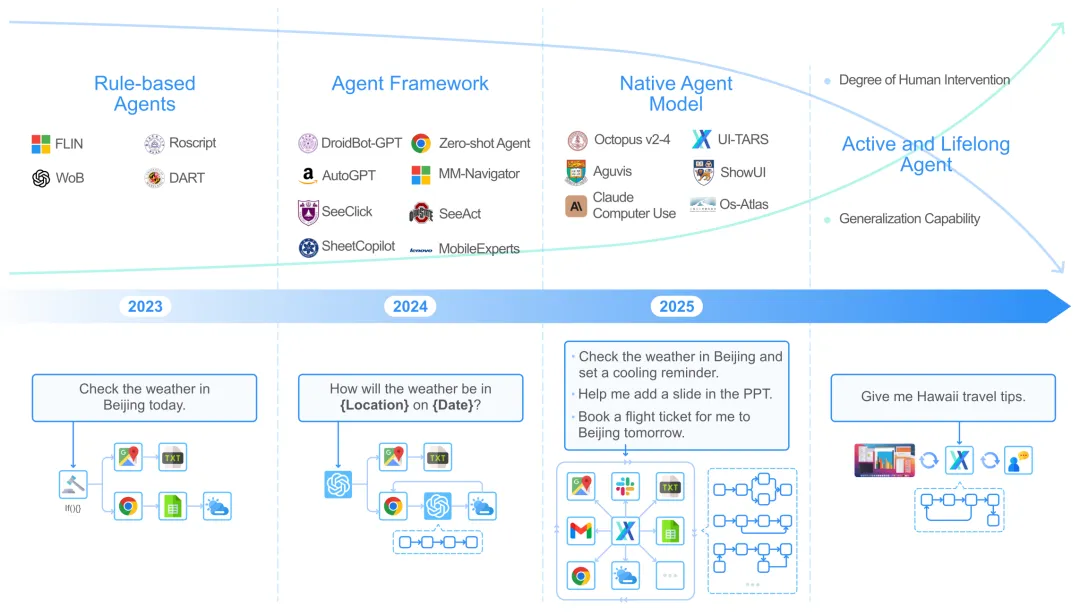

① 从框架整合到统一模型:让智能体实现自动适应的关键

智能体的演进正从框架(framework)向模型(model)转变。

智能体的演进

早期的 Agent Framework 依赖外部模块组合基础大模型,尽管具备一定灵活性,但存在适应性弱、耦合度高、维护成本大的问题。

UI-TARS 属于“原生智能体模型(Agent Model)”,具备完整的感知-推理-记忆-行动一体化结构,能在训练中不断积累知识与经验,具备更强的泛化能力与适应能力。

这种“从数据出发”的闭环范式,使得 UI-TARS 不再依赖人工规则与提示工程,也无需重复设定交互步骤,极大降低了开发门槛。

② System 2:让智能体走向深度认知的关键

通过从心理学的“System 1 & 2”理论中汲取灵感,UI-TARS 在保留低延迟的直觉式反应能力(System 1)的基础上,引入了具备规划与反思能力的 System 2 推理系统。

通过“思维(thought)”机制,模型在执行前生成一段中间 reasoning trace,模拟人类思考流程,帮助其更有逻辑地完成任务。

这也使得 UI-TARS 不只是完成指令,而是真正理解并完成任务目标。

③ 学习机制:让智能体能持续进化的关键

UI-TARS 核心架构包括感知、操作、记忆及推理能力模块:感知能力模块构建了包含 UI 类型、位置、视觉特征、功能属性的结构化数据;操作能力模块统一了不同平台下的控制语义,实现标准化操作空间;记忆能力模块能记录并利用历史交互经验进行行为优化;推理能力模块实现整合任务指令、视觉观测、历史轨迹进行多轮反思与重规划。

其中,UI-TARS 的核心推理模块能基于多模态模型生成“思维-动作”序列,并通过实际环境反馈进行自我调优。

4. 写在最后

作为 UI-TARS-2.0 的预览版,UI-TARS-1.5 已经展示出了强化学习这一技术路线在 GUI agent 领域的较高潜力。尽管构建一个完全基于动态环境的端到端强化学习系统仍然存在诸多困难和挑战,我们坚信这是曲折但正确的道路。

未来,我们将继续通过强化学习提升 UI-TARS 在复杂任务中的性能表现,期望达到接近人类的水平,同时将继续优化 UI-TARS 的产品体验,进一步提升使用流畅度并丰富交互能力。