23篇成果入选,2场交流活动,字节跳动Seed邀你相聚ICLR 2025

23篇成果入选,2场交流活动,字节跳动Seed邀你相聚ICLR 2025

日期

2025-04-23

分类

学术活动

ICLR 2025 在新加坡拉开帷幕。作为机器学习领域的顶级学术会议之一,ICLR 聚集了来自全球的学者与产业界代表。

今年,字节跳动 Seed 团队共有 23 篇成果被接收或邀请分享,包含 1 篇 Oral、1 篇 Spotlight,涵盖 LLM 推理优化、图像生成、视觉-语义对齐、视觉自回归等多个方向。

活动期间,我们在现场 L07 区域设置展台,呈现 Seedream 3.0、UI-TARS、豆包实时语音模型等多项前沿技术成果。届时,Seed 团队多个方向的技术负责人与研究员会在现场与大家分享交流!

1. 现场活动

• verl Expo Talk 分享

时间:4 月 26 日 13:00 - 14:00 (GMT+8)

地点:活动现场 Peridot 202 - 203

主题:《verl: Flexible and Efficient Infrastructures for Post-training LLMs》,RLHF 开源框架 verl 的核心参与者将进行技术研发与落地经验分享。

• 首届 Open Science for Foundation Models (SCI-FM) Workshop

时间:4 月 28 日 09:00 - 17:10 (GMT+8)

地点:活动现场 Hall 4 #5

简介:由字节跳动 Seed 参与举办的首届 SCI-FM Workshop 聚焦大模型的开源与透明化研究,涵盖数据集构建、训练策略、评价体系等多个核心话题。Workshop 将邀请国内外基础模型领域的学者共同探讨,助力大模型的开放与发展。更多详情请查看:https://open-foundation-model.github.io/

2. 精选 Paper

我们精选了中选或受邀分享的 6 篇论文:

FlexPrefill:一种用于高效长序列推理的上下文感知稀疏注意力机制

论文地址:https://arxiv.org/pdf/2502.20766

演讲安排:4月24日 10:30-12:00, Oral Session 1A

LLMs 在长序列推理过程中面临计算挑战,尤其在注意力预填充阶段,其复杂度会随着输入长度的增长而呈平方级增长。此前的解决方案主要依赖于固定的稀疏注意力模式或基于有限样本离线搜索稀疏化方案。然而,这些方法缺乏灵活性,难以有效适应不同的输入需求。

我们提出了一种名为 FlexPrefill 的灵活稀疏注意力机制,它能够实时动态调整稀疏注意力模式和计算预算,以满足每个输入和注意力头的具体需求。FlexPrefill 的创新点包括两个核心组件:

1)查询感知稀疏模式判定:通过测量真实分布和估计分布间的 Jensen-Shannon 散度,该组件可以在查询感知的灵活稀疏注意力模式和预定义的结构化注意力模式之间自适应切换。

2)基于累积注意力的索引选择:该组件根据不同的注意力模式动态选择需要计算的注意力块索引,并确保注意力分数的总和满足预设的阈值,从而更好地平衡模型效果和运算效率。

FlexPrefill 能够根据输入动态优化每个注意力头的稀疏模式和稀疏比率,从而提升长序列推理任务的效率。实验结果显示,该方法在速度和准确性方面有显著提升,在 128k 长度的输入下能提供 3.5 倍的加速并保持模型效果,且在百万长度序列上提供超过 10 倍的加速。FlexPrefill 允许自由调整加速比率并在不同加速比下始终保持优秀性能,为 LLM 推理提供了更加灵活高效的解决方案。

MaskBit:基于比特 Token 的无嵌入图像生成

论文地址:https://arxiv.org/pdf/2409.16211

基于掩码的 Transformer 架构在类别条件图像生成中,逐渐成为扩散模型的有力替代方案。这类框架通常包含两个阶段:第一阶段是使用 VQGAN 模型,将图像从像素空间投影到潜在空间;第二阶段通过 Transformer 在潜在空间内生成图像。这种设计为图像合成提供了极大的潜力。

在本研究中,我们的主要贡献包括两个方面:

1)对 VQGAN 的系统性研究与改进:我们构建了一个透明、可复现且性能优越的 VQGAN 模型,不仅公开了此前未披露的细节,还提升了模型的可获取性,并在性能上达到了当前最先进方法的水平。

2)提出无嵌入的生成网络:我们设计了一种基于 Bit Token(即二进制量化表示,并包含丰富语义信息)的全新生成框架。实验结果表明,基于 Bit Token 的无嵌入图像生成方法,在 ImageNet 256 × 256 基准测试中取得了新的最优 FID 分数 1.52,且生成器模型仅有 305M 参数,具备极高的效率和紧凑性。

Shot2Story:一个用于全面理解多镜头视频的新基准

论文地址:https://arxiv.org/pdf/2312.10300

一段视频短片可能包含多个事件的进展和有趣的故事线。为理解背后的故事,人类需要捕捉每个镜头中的事件并将其关联起来。在本研究中,我们提出了一个全新的多镜头视频理解基准 ——Shot2Story,旨在推动多模态视频理解的发展。

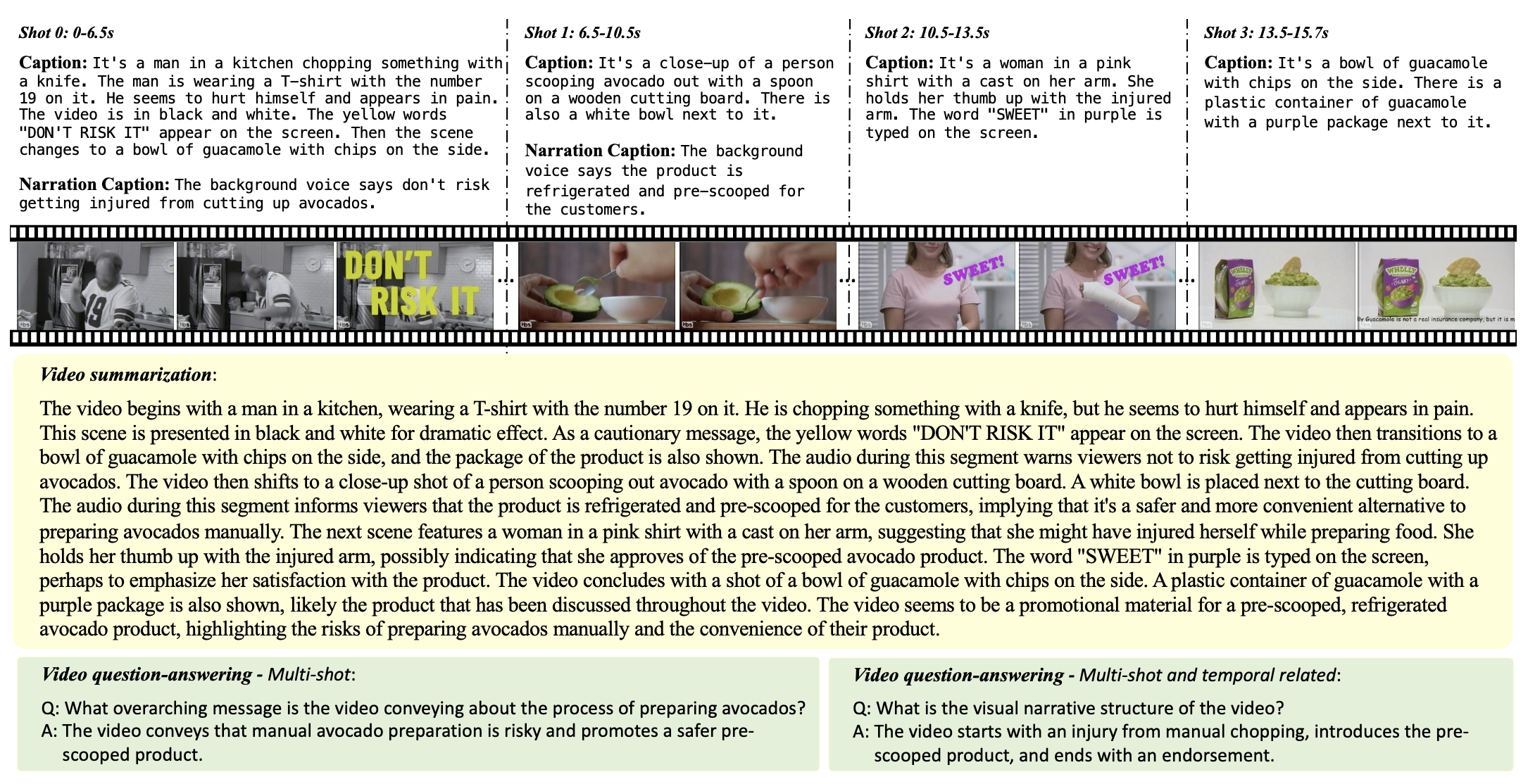

Shot2Story 标注示例:单镜头视觉和语音描述,多镜头视频总结与问答对

Shot2Story 包含 42,958 个多镜头短视频,为每个视频提供了人工标注的详细镜头级视觉和语音描述、视频总结及问答对。与现有数据集相比,Shot2Story 通过更细粒度的标注覆盖了单镜头视听描述、多镜头总结和问答等任务,显著提升了视频理解的挑战性和多样性。

实验表明,基于 Shot2Story 训练的模型在长视频总结和复杂问答任务上表现优异,生成的文本总结能够精准描述事件进程并捕捉镜头间的逻辑关系。Shot2Story 的发布为多模态视频理解提供了一个高质量测试平台,推动了复杂视频分析和跨模态学习的进步。

为什么大语言模型 LLMs 的有效上下文长度不足?

分布式训练技术和高效注意力机制的进步显著扩展了大语言模型(LLMs)的上下文窗口长度。然而,近期研究发现,开源 LLMs 的有效上下文长度往往远低于其训练长度,通常不超过一半。我们发现,这一问题的核心原因在于:模型在预训练和后训练阶段形成的相对位置频率分布的左偏现象,这一现象阻碍了模型有效获取远距离信息的能力。

为解决这一问题,我们提出了一种无需额外训练的推理方法 ——STRING(ShifTed Rotary position embeddING),通过在推理过程中将训练良好的高频位置索引覆盖原本无效的位置索引,从而在现有训练长度内显著提升模型性能。

实验结果表明,STRING 在无需重新训练的情况下,大幅提升了如 Llama3.1 70B 和 Qwen2 72B 等主流开源模型的长上下文性能。

在 RULER 和 InfiniteBench 等长上下文基准测试中,STRING 使这些模型的性能提高超过 10 分,并超越了包括 GPT-4-128k、Claude-2 等商业模型。

Mamba 架构在视觉领域的自回归预训练

视觉领域社区近期将状态空间模型 Mamba 应用于多项任务,但其扩展能力和训练效率仍有待提升。

为此,我们提出了一种新型自回归视觉预训练方法——ARM(Autoregressive Mamba),通过结合 Mamba 的线性注意力机制和逐步自回归建模策略,显著提升了其在视觉任务中的效率和性能。

ARM 通过将相邻图像块分组为预测单元,降低了计算复杂度,同时加快了训练速度。实验表明,ARM 在 ImageNet 上实现了 85.0% 的精度(输入尺寸 224×224),扩展到 384×384 时提升至 85.5%,显著超越其他 Mamba 变体。此外,ARM 在图像外域测试(如 ImageNet-A、ImageNet-R 等)中表现出更强的鲁棒性和泛化能力,其训练效率更是比对比学习和掩码建模方法高出一倍,仅需 34 小时即可完成基准预训练。

ARM 的提出为 Mamba 在视觉领域的应用奠定了基础,不仅解决了其在大规模模型训练中的稳定性问题,还为长序列建模和多模态研究提供了新方向,推动了视觉任务性能的极限。

3DitScene:通过语言引导的可分离高斯分布实现任意场景编辑

场景图像编辑在娱乐、摄影和广告设计中至关重要。我们提出了一项创新的场景编辑框架 3DitScene,通过语言引导的 3D 高斯分布(Language-guided Disentangled Gaussian Splatting) 实现从 2D 到 3D 的无缝场景编辑。

给定任意图片,支持 object 层面的各种 3D 编辑

不同于传统仅关注 2D 或全局 3D 编辑的方法,3DitScene 提供了一种统一的场景表示方式,既支持全局场景的灵活调整,又能实现对单个对象的精确操作,赋予用户对场景构图和对象编辑的强大控制力。通过将 CLIP 提取的语言特征嵌入 3D 几何并结合生成模型(如 Stable Diffusion)优化场景表示,3DitScene 从单一图像生成高质量的 3D 表现,同时保证编辑过程的 3D 一致性与渲染质量。

实验结果表明,3DitScene 在对象操作(如移动、旋转、删除)和相机控制上均显著优于现有方法,同时在图像一致性和细节质量上表现不错。特别是支持的对象级分离和场景布局增强,有效提升了遮挡区域的视觉表现和整体编辑效果。