Seed Research|4B 模型数学推理接近 235B 表现,Seed 最新强化学习配方全面开源

Seed Research|4B 模型数学推理接近 235B 表现,Seed 最新强化学习配方全面开源

日期

2025-07-15

分类

Seed Research

近日,字节跳动 Seed 联合香港大学、复旦大学公布最新强化学习训练方法 POLARIS。通过精心设计的 Scaling RL 方法,小模型的数学推理能力也能被提升到超大模型的水平。

实验结果表明,通过以待训练模型为中心的数据和训练参数配置,POLARIS 能使 4B 参数开源模型(Qwen3-4B)在 AIME25 和 AIME24 数学测试中分别达到 79.4% 和 81.2% 的准确率,性能超过部分更大规模的闭源模型。同时,POLARIS-4B 的轻量化,允许其在消费级显卡上部署。

POLARIS 的详细训练方法、训练数据、训练代码和实验模型已全部开源,欢迎大家体验交流!

GitHub 主页: https://github.com/ChenxinAn-fdu/POLARIS

Hugging Face 主页: https://huggingface.co/POLARIS-Project

业界此前的 RL 训练配方,如 DeepScaleR,已展示了 Scaling RL 在较弱基础模型上强大的效果。然而,对于目前最前沿的开源模型是否也能复现如此显著的提升效果,仍存在诸多未知。对此,POLARIS 联合研究团队给出明确回答:依然可以。

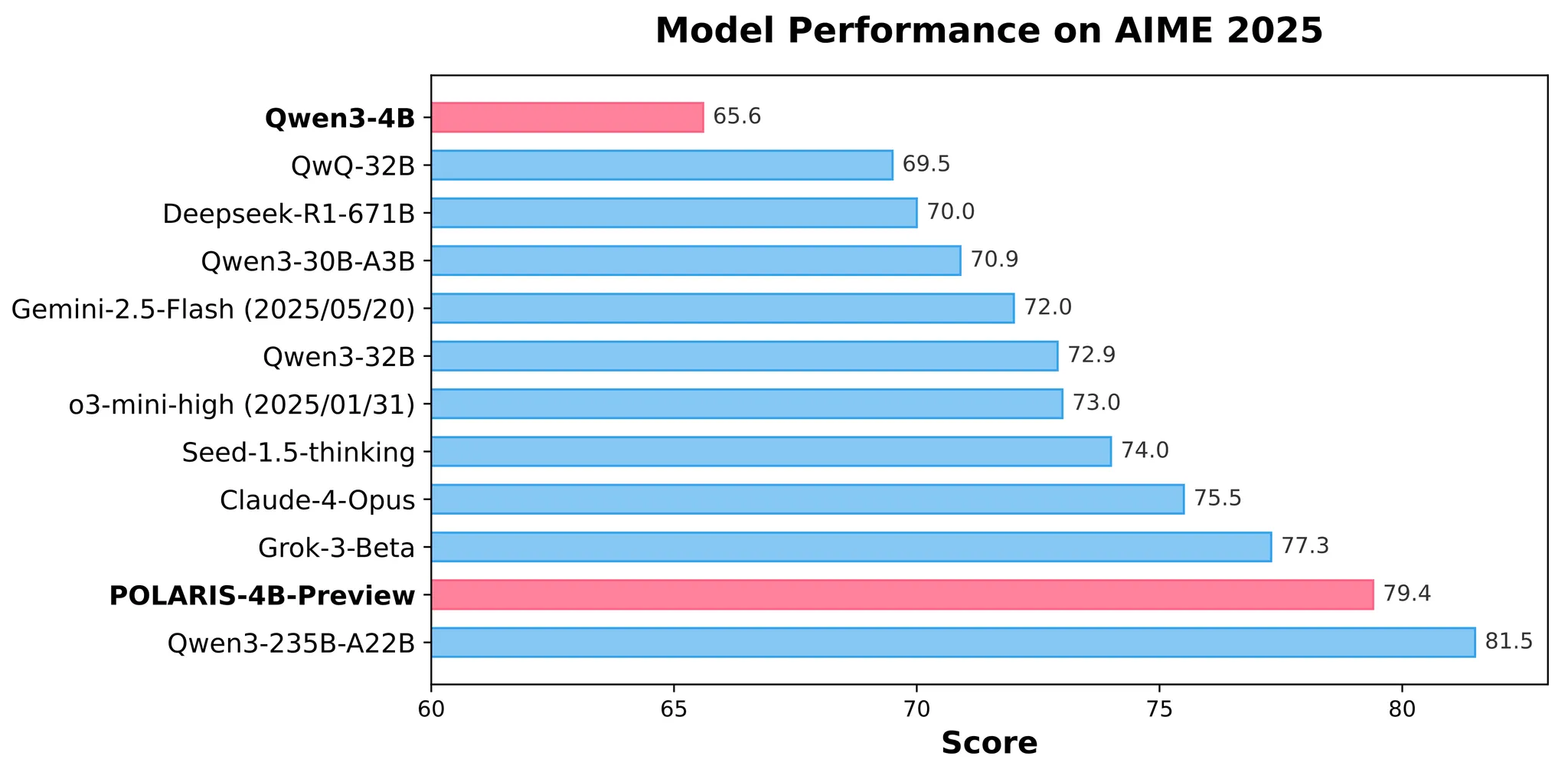

不同模型在 AIME 2025 上的表现

具体来说,POLARIS 通过仅 700 步的 RL 训练,成功让 Qwen3-4B 在数学推理任务上表现接近其 235B 版本。只要方法得当,RL 仍存在着巨大的开发潜力。

团队在探索中最重要的心得是:训练数据及超参数设置要围绕待训练的模型进行设置。

1. 训练数据构建中,动态提升样本难度

训练数据初始化

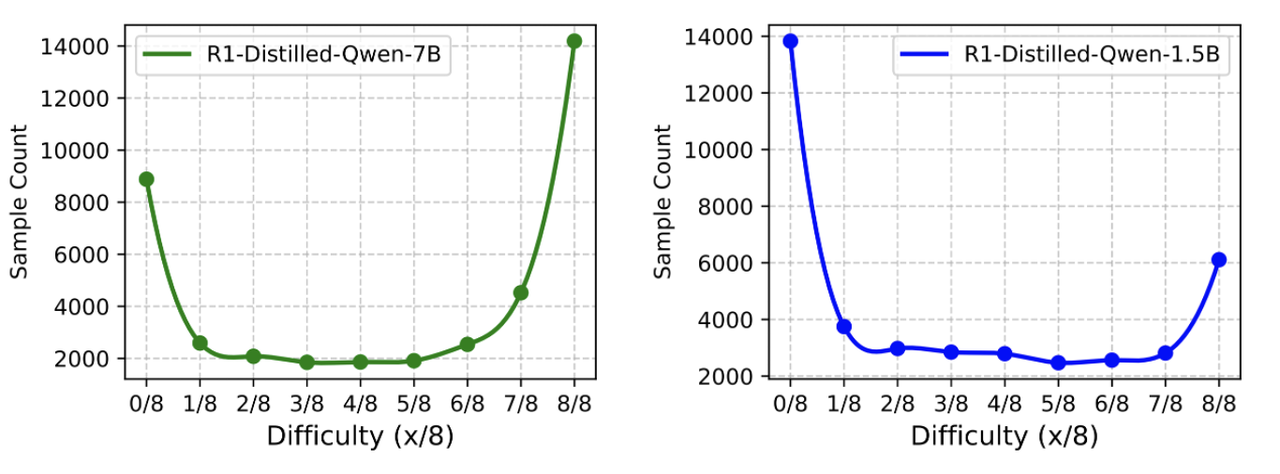

团队发现,对于同一份数据,不同能力的基础模型展现出的难度分布呈现出镜像化的特征。对于训练集 DeepScaleR-40K 中的每个样本,团队使用 R1-Distill-Qwen-1.5B/7B 两个模型回答分别推理了 8 次,统计其中正确次数,以此衡量每个样本的难度水平。

DeepScaleR-40K 数据集难度分布,由 DeepSeek-R1-Distill-Qwen-1.5B/7B 估算

实验结果显示,大多数样本位于两端,要么太难,要么太简单(8/8 正确解答或 0/8 正确解答)。对于 1.5B 模型,该分布向难题倾斜,可对于 7B 模型,该分布向简单题倾斜。说明该数据集虽然对 1.5B 模型具有挑战性,却不足以有效训练 7B 模型。

POLARIS 提出构建轻微偏向难题的数据分布,形状就像镜像 J。过度偏向简单题或难题的分布,都会使得无法产生优势的样本在每个 batch 中占有过大的比例。在 POLARIS 构建的过程中,团队对开源数据集 DeepScaleR-40K 和 AReaL-boba-106k 进行了筛选,剔除所有 8/8 正确的样本,最终形成了 53K 规模的数据集。

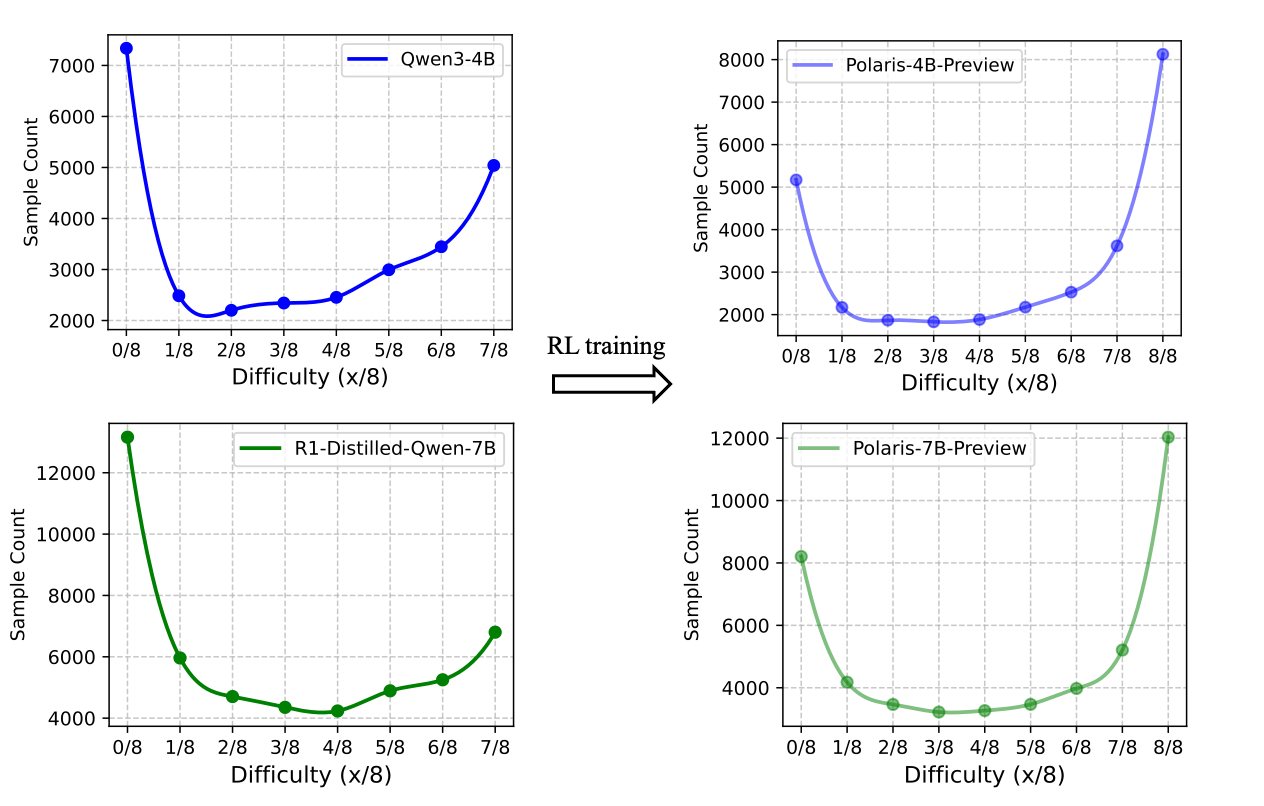

训练数据动态调整

既然已经得到了好的初始化数据,那么用这份数据进行训练到底是不是一个好的选择?

随着强化学习训练推进,数据难度分布逐渐向更简单的问题偏移

答案是否定的。在强化学习训练过程中,模型对训练样本的“掌握率”会提高,难题也会变成简单题。为此,团队在训练中引入了数据动态更新策略。训练过程中,每个样本的通过率会随着 reward 计算而实时更新。在每个训练阶段结束时,准确率过高的样本将被删除。

2. 采样控制中,以提升多样性为核心

在 RL 训练中,多样性被视为提升模型表现的重要因素。好的多样性使模型能探索更广泛的推理路径,避免在训练早期陷入过于确定的策略中。

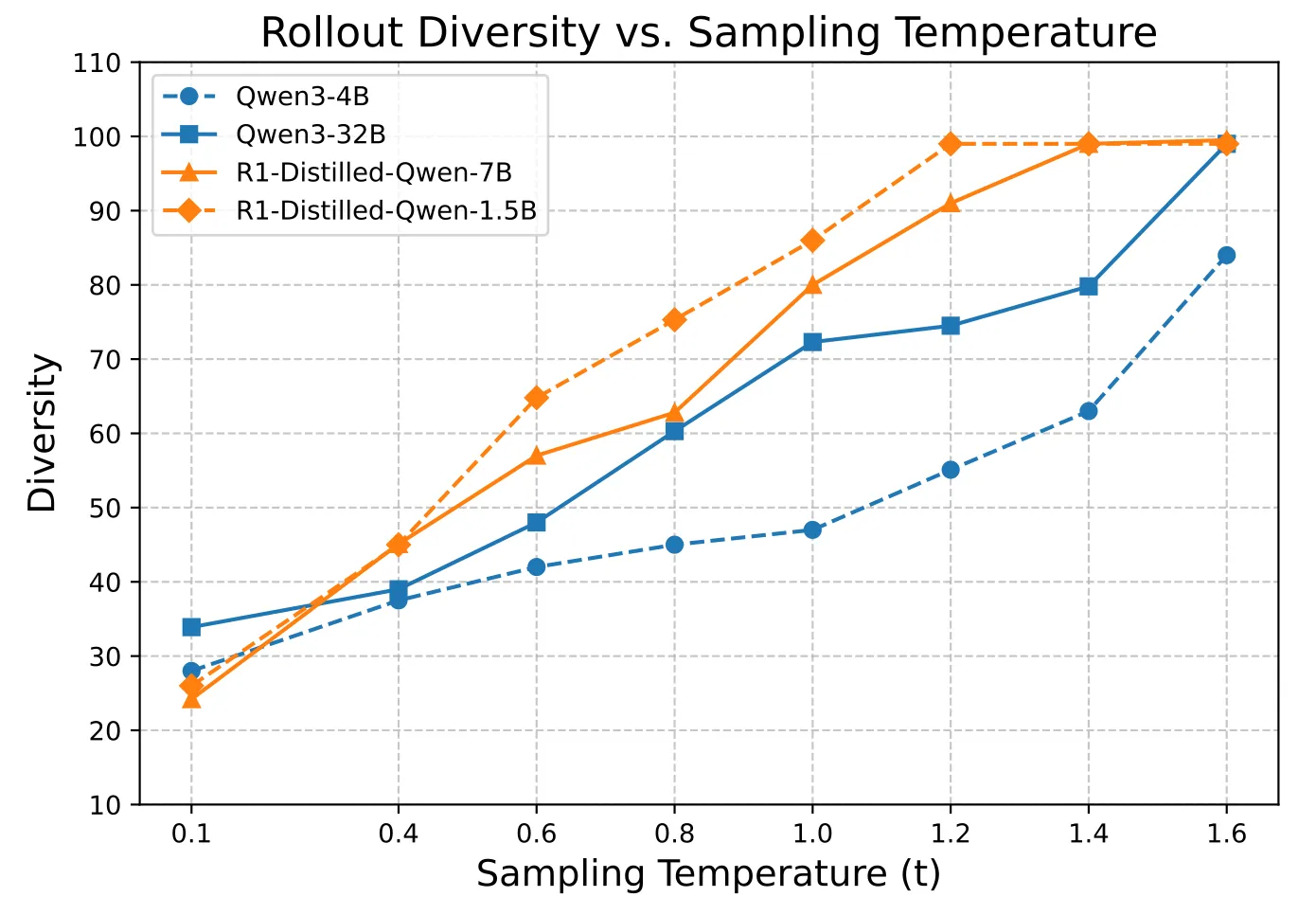

Rollout 阶段的多样性主要通过 topp、topk 与温度 t 来调控。当前大多数工作都采用 topp=1.0 和 topk=-1,这已经达到了最大的多样性。而采样温度 t 还没有统一的设置。

目前主流的 t 设置方法有两种:采用建议的解码温度,如 Qwen3 在 demo 中设置的 0.6;或者直接设置为一个整数 1.0。但在 POLARIS 的实验中,这两种做法都不是最优方法。

温度、性能与多样性的平衡之道

团队通过一系列实验,分析了采样温度与模型准确率及路径多样性之间的关系。为量化采样轨迹的多样性,团队采用了 Distinct N-gram 指标(n=4),该指标用于衡量生成文本中独特连续词组的比例:分数越接近 1.0,说明生成内容越多样;反之则重复率较高。

路径多样性与采样温度的关系

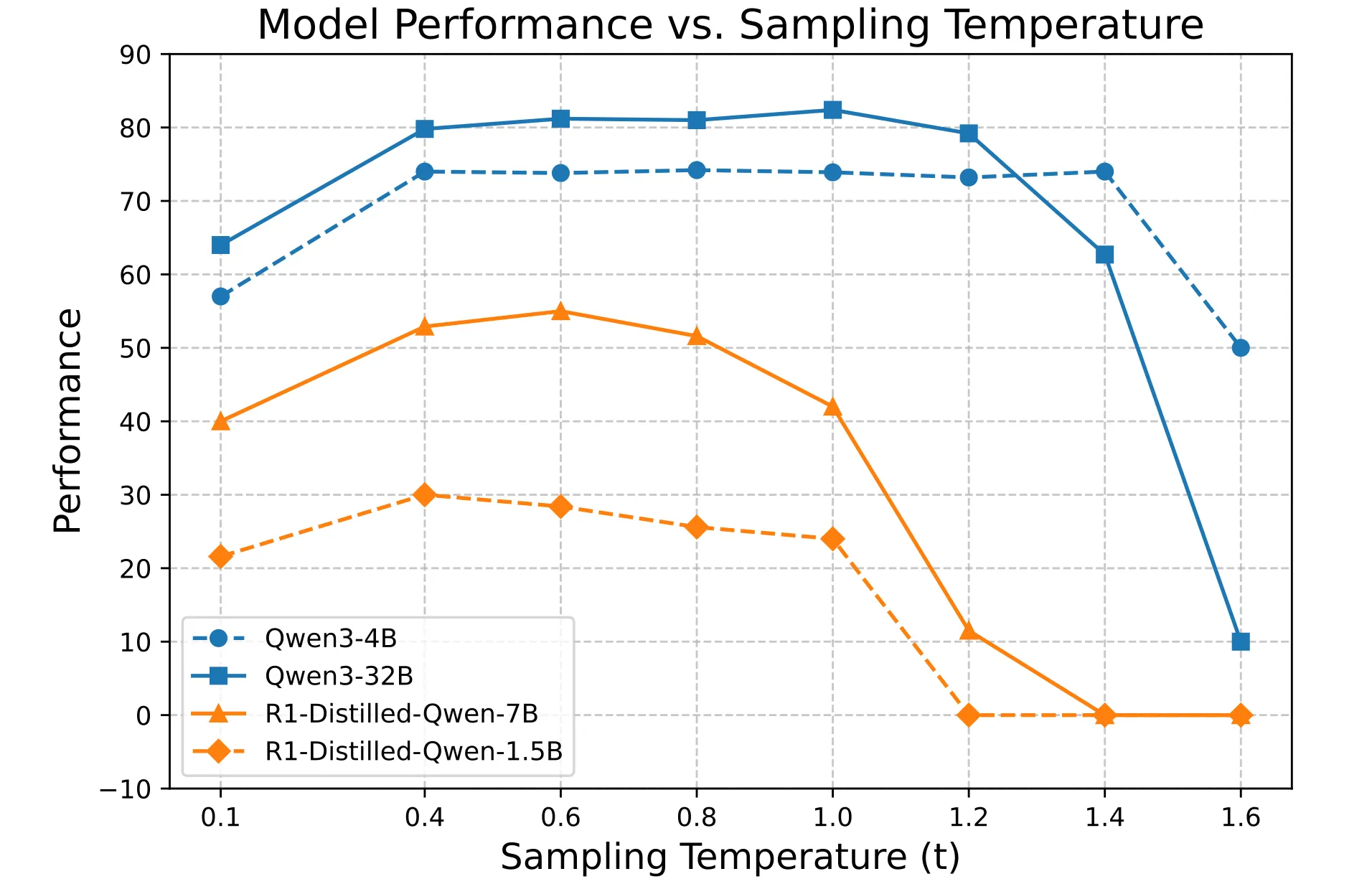

结果显示,较高的温度能显著提升多样性,但不同模型在相同温度下,表现也存在较大差异。从上图来看,对于这两个模型,如果以 0.6 作为采样温度明显多样性不足。

当然温度设置也并非越大越好,需要考虑性能的变化。

模型表现与采样温度的关系

团队发现模型性能随温度升高呈现“低-高-低”的趋势。假如把采样温度设置为 1.0,这对于 Deepseek-R1-distill 系列模型过高了,而对于 Qwen3 系列来说又有些低。这说明理想温度的设计需要针对待训练模型进行精细校准,没有一个超参数是适配所有模型的。

温度区间的定义

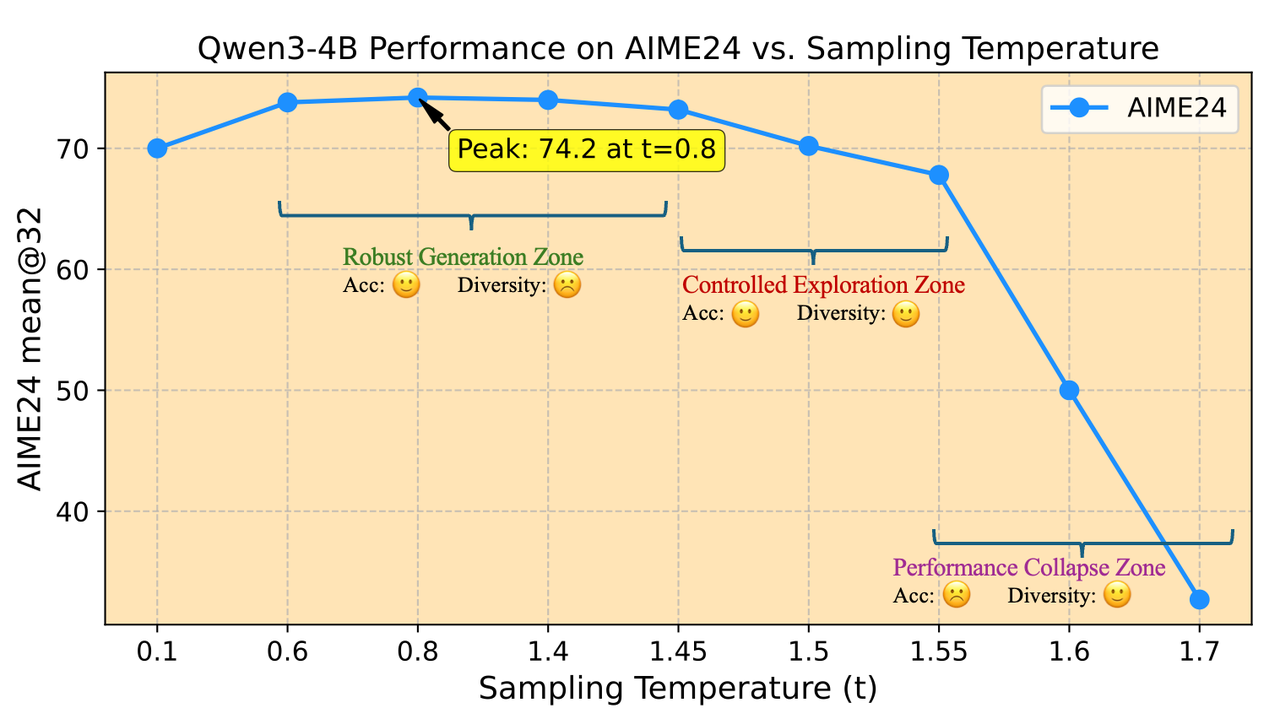

团队基于实验趋势归纳出模型采样温度的三个区域:

Qwen3-4B 模型表现与采样温度

- 鲁棒生成区:在该区域内,性能波动较小,测试阶段解码温度通常就选自鲁棒生成区。

- 控制探索区:此区域的温度虽然会导致模型性能较鲁棒生成区略有下降,但降幅在可接受范围内,同时能显著提升多样性,适合作为训练温度使用。

- 性能崩塌区:当采样温度超出一定范围时,模型性能急剧下降。

从控制探索区进行温度初始化

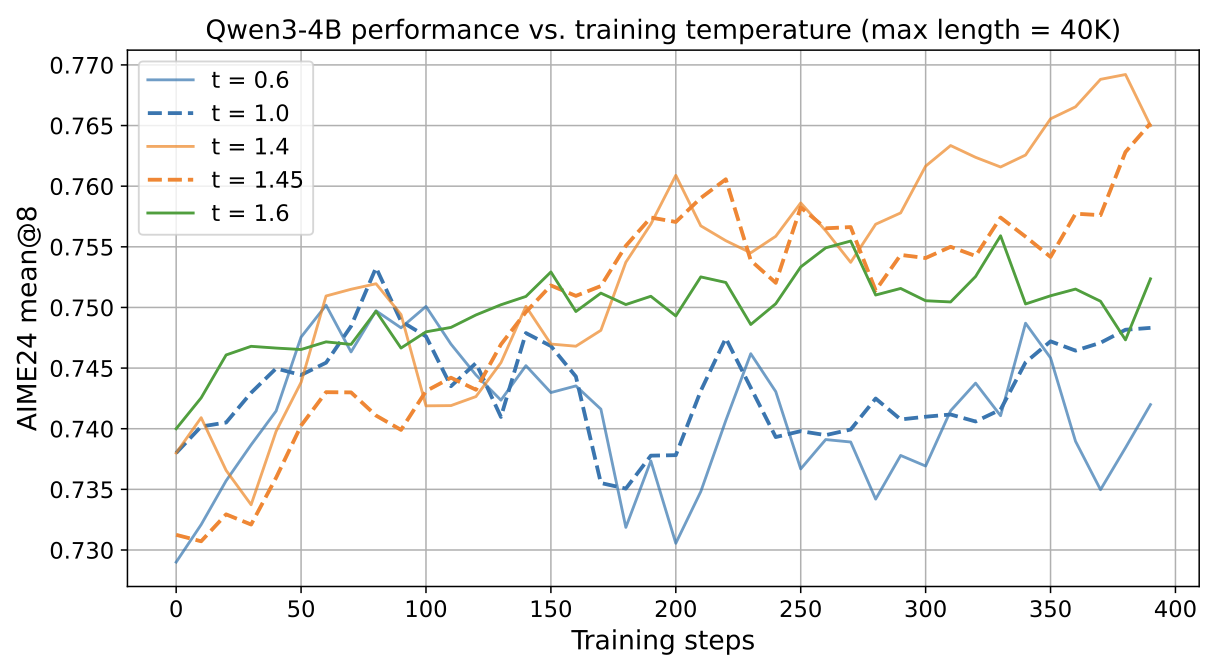

根据上图规律,团队在 POLARIS 项目中提出:以控制探索区的温度作为初始化温度。POLARIS 把 Qwen3-4B 的初始训练温度设置为 1.4,实验显示,常用的 t=0.6 或 t=1.0 设置因为温度过低,限制了模型的探索空间,导致难以挖掘 RL 潜力。

Qwen3-4B 模型表现与训练温度

动态温度调整

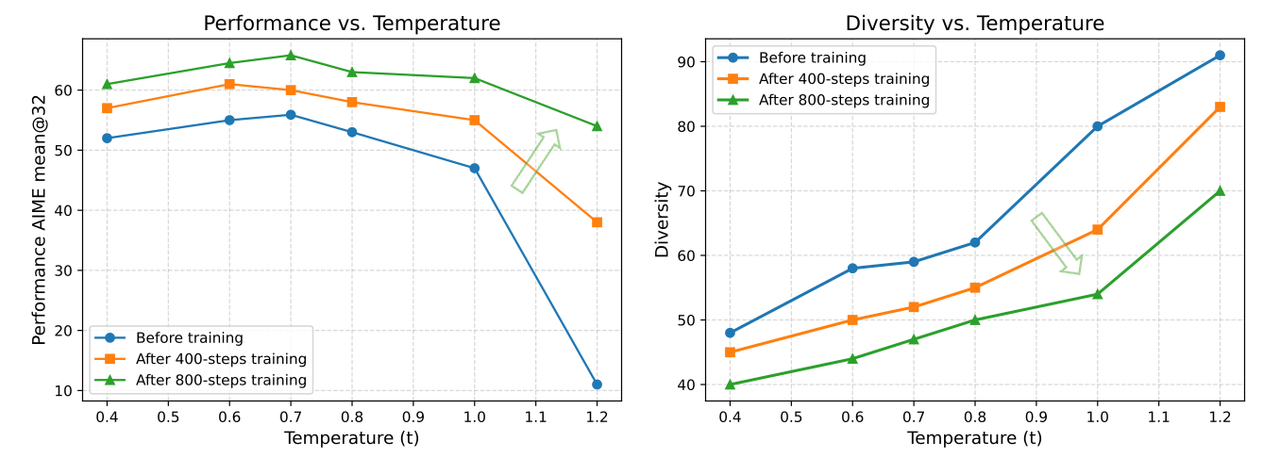

在模型性能增长的同时,多样性同样也会发生偏移。随着训练收敛,各路径间共享的 N-gram 比例增加,探索空间随之缩小。

温度对模型表现、路径多样性的影响

整个训练过程中始终使用最开始的温度,会导致后期多样性不足。因此,团队提出在 RL 训练过程中动态更新采样温度的策略:在每个阶段开始前,都进行和温度初始化时类似的搜索方法,使得后续阶段起始的多样性分数和第一阶段的相似。举个例子,假如第一阶段开始的多样性分数是 60, 那此后的每个阶段,团队都会选择一个能把多样性分数提升到 60 的温度来进行训练。

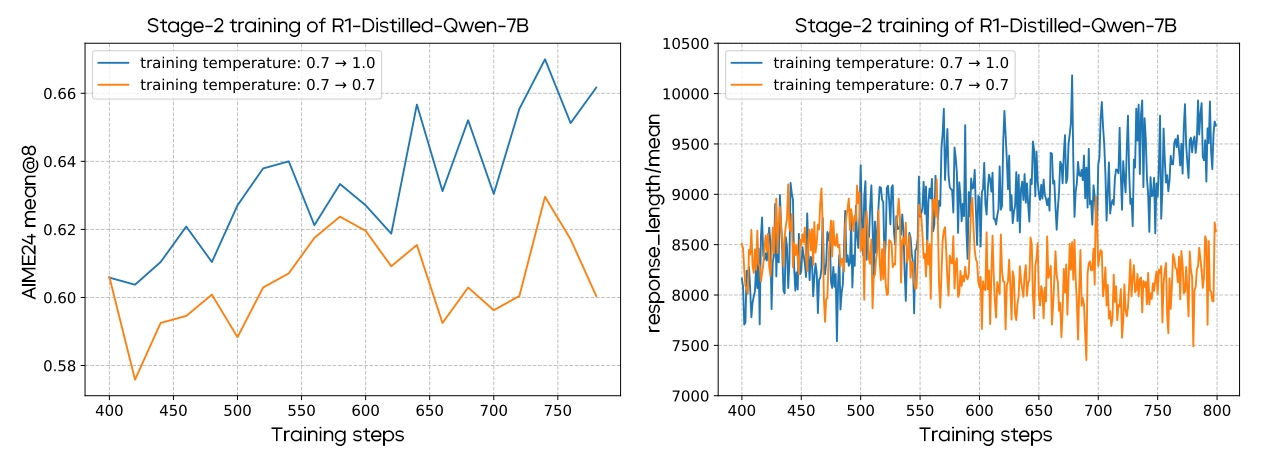

对比实验中,从训练开始到结束都采用同一温度,其效果不及多阶段温度调整。多阶段温度调整不仅带来了更优的 RL 训练效果,还使得回答长度的提升更加稳定。

多阶段温度调整效果

3. 引入长度外推技术,拓展 RL 思维链

在训练 Qwen3-4B 的过程中,一个显著难题在于长上下文训练。因为模型本身的回答长度已经很长,要继续训练模型作出更长回答需要高昂的计算成本。Qwen3-4B 的模型预训练上下文长度为 32K,RL 阶段 POLARIS 将最大训练长度设定为 52K,但实际达到最大序列长度的训练样本比例不足 10%。这意味着真正使用长文本进行训练的样本非常有限。

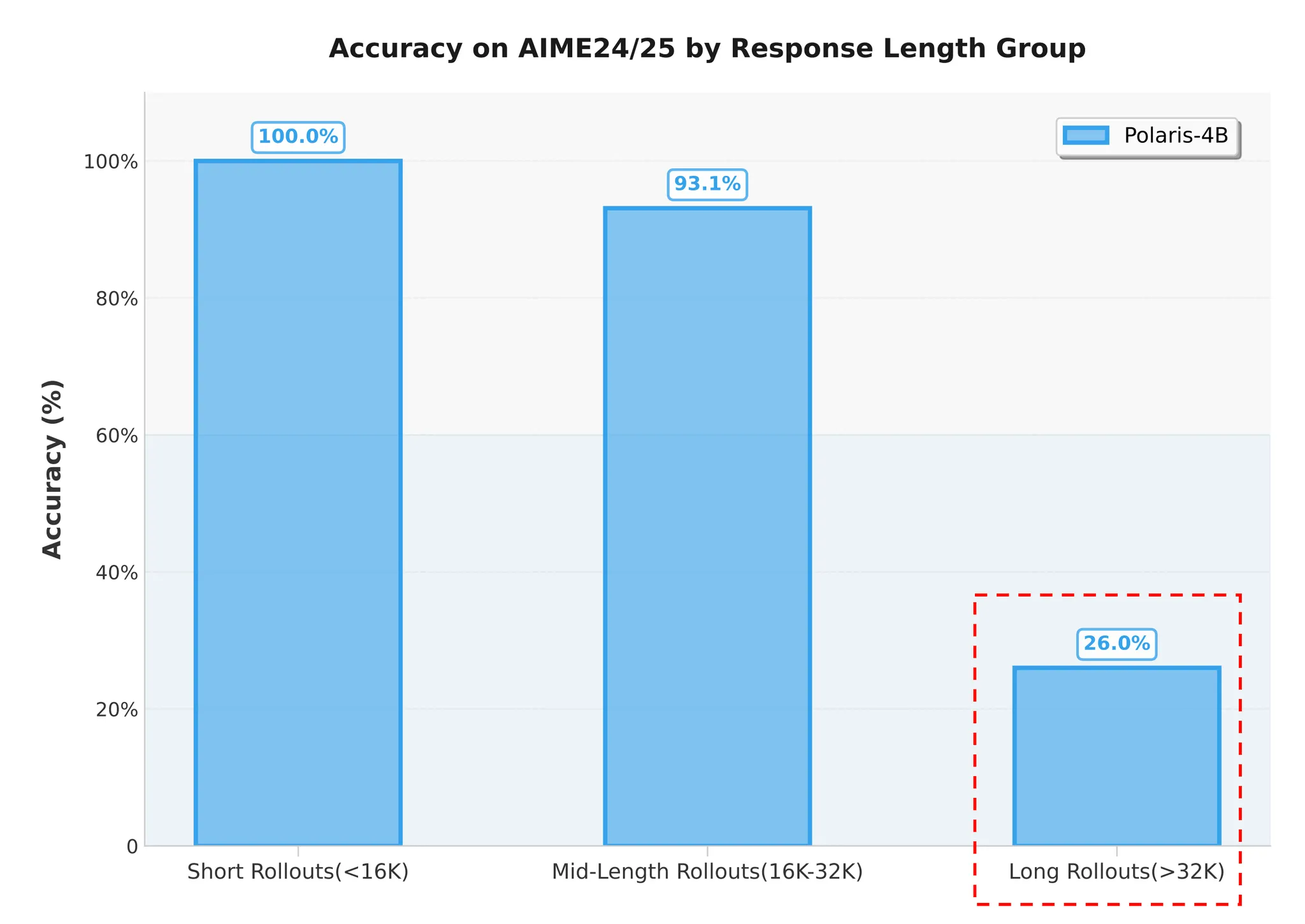

超过预训练长度后模型性能下降

为评估 POLARIS-4B-Preview 的长文生成能力,团队选取了 AIME 2024/25 中的 60 道题,每道题进行 32 次推理,总计 1920 个样本,并按照回答长度将其分为三组:

- 短文本组: 回答长度小于 16K;

- 中等文本组:回答长度介于 16K 到 32K;

- 长文本组: 回答长度超过预训练长度 32K。

不同回答长度的模型准确性

统计结果表明,长文本组的准确率仅为 26%,证明模型在生成超过预训练长度的长 CoT 时,性能明显受限。

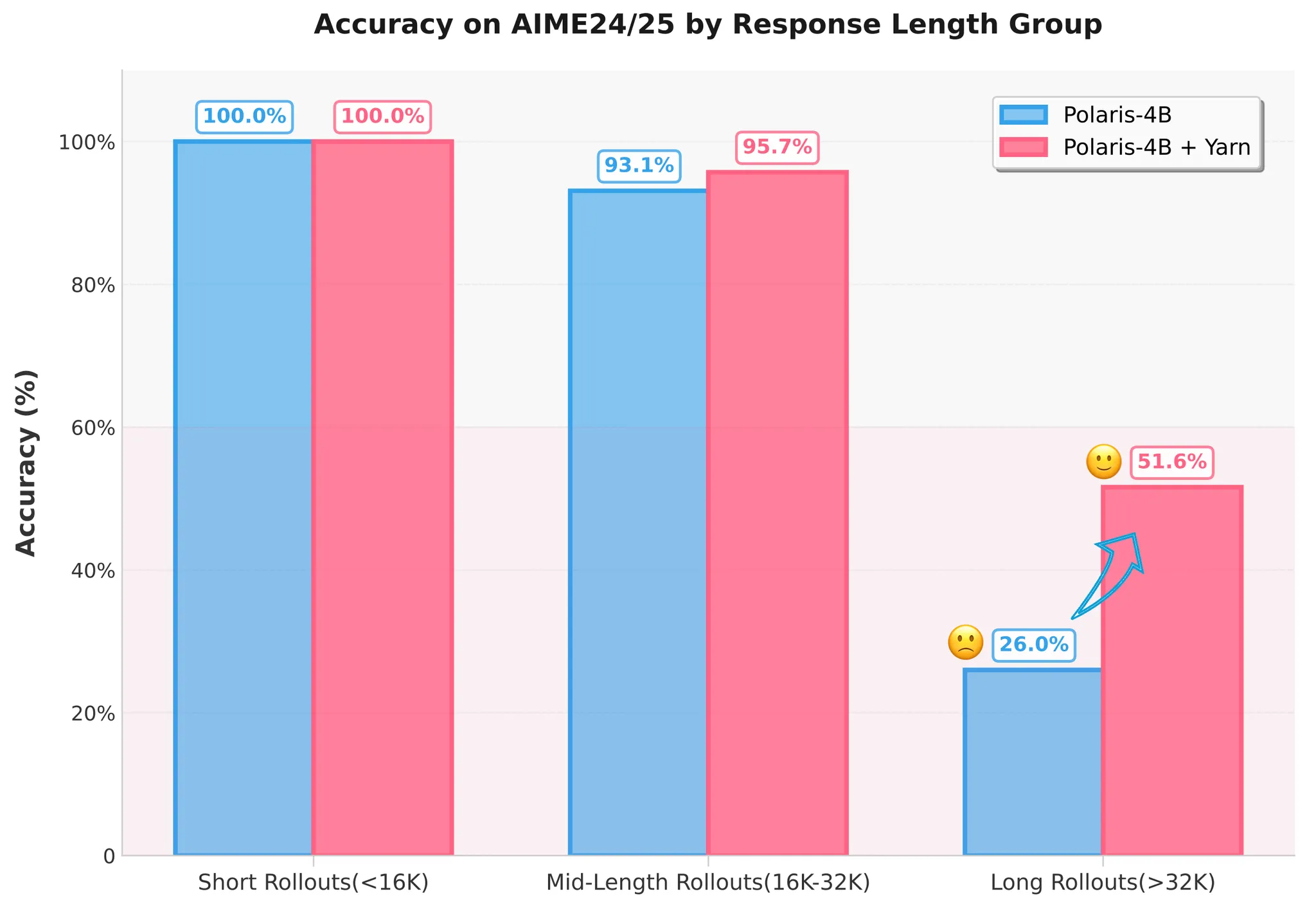

无需额外训练的长度外推技术

既然 RL 在长上下文的情况下存在劣势,那么长 CoT 性能不佳可能是由于长文本训练不充分导致。针对长文本训练样本不足的问题,团队引入了长度外推技术。通过位置编码 RoPE 的调整,模型能够在推理时处理超出训练时所见的更长序列,进而补偿长文本训练中的不足。具体实现上,团队采用了 YaRN 作为外推方法,并设置扩展因子为 1.5,如以下配置所示:

"rope_scaling": {

"attn_factor": 1.0,

"factor": 1.5,

"rope_type": "yarn"

}

实验结果显示,通过应用该策略,模型对超过 32K 长度回答的准确率由 26% 提升至超过 50%。

应用 YaRN 后的模型准确率

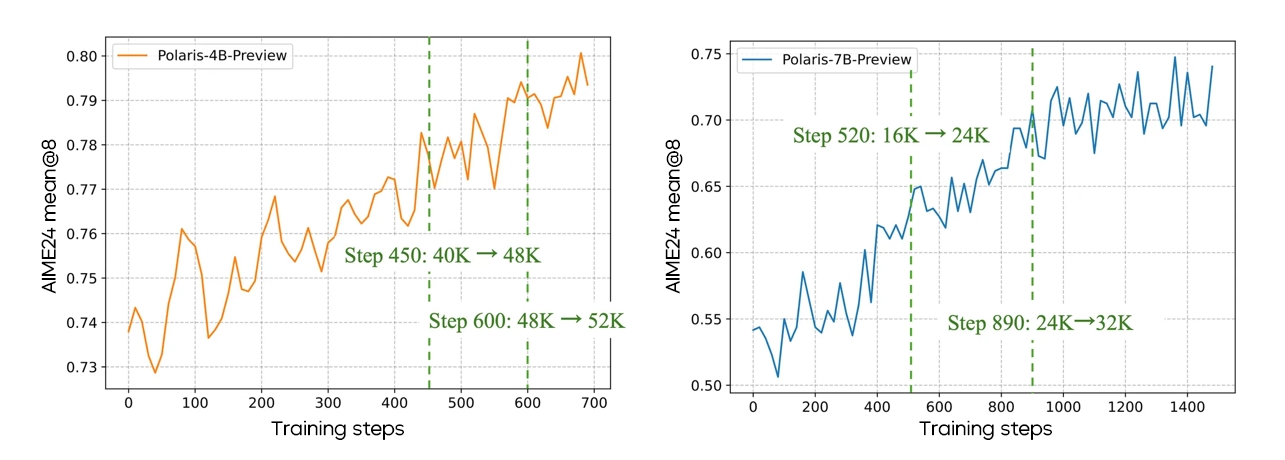

4. 多阶段 RL 训练中,直接让模型“长思”更稳妥

POLARIS 采用多阶段的训练方式,在早期阶段,模型使用较短的上下文窗口;待模型表现收敛后,再逐渐增加上下文窗口的长度以拓宽模型的推理能力。

4B 模型从更高的基线开始训练,因为 Qwen3-4B 的性能优于 DeepSeek-R1-Distill-Qwen-7B。

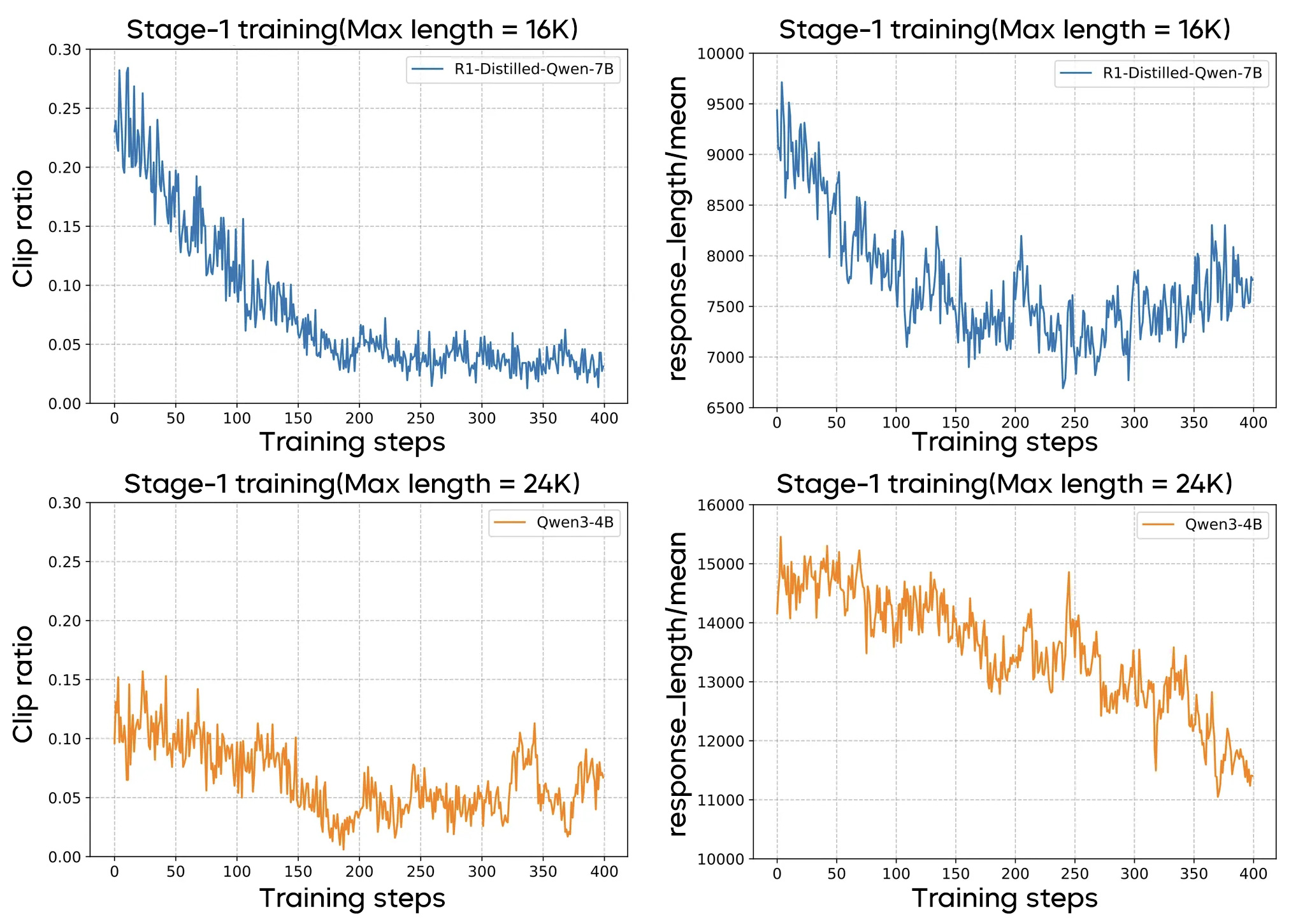

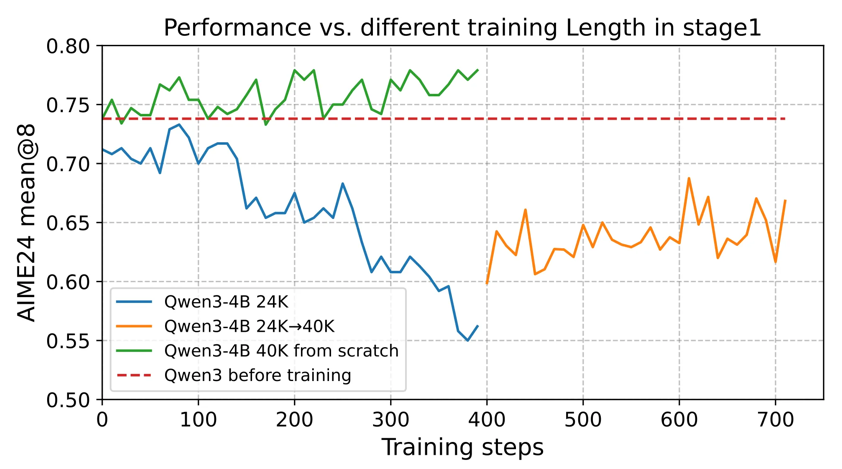

“think shorter, then longer”是否适用所有模型?

尽管这一策略对某些模型有效,但在多阶段的训练中,初始阶段选择合适的最大响应长度至关重要,不同基础模型的 token 利用效率存在差异。团队发现,对于 DeepSeek-R1-Distill-Qwen-1.5B/7B,采用较短的响应长度训练效果较好;但对 Qwen3-4B 来说,即使响应长度只有 24K 且响应截断比例低于 15%,其性能也会急剧下降,这种下降即使在后期阶段也难以恢复。因此直接让模型“长思”更为稳妥。

第一阶段训练长度与模型表现

对于 Qwen3-4B 来说,从开始便采用 40K 的最大长度,其性能呈现稳定上升趋势,而第一阶段采用 24K 而后升级至 40K 的方案则不尽理想。

第一阶段训练长度与模型表现

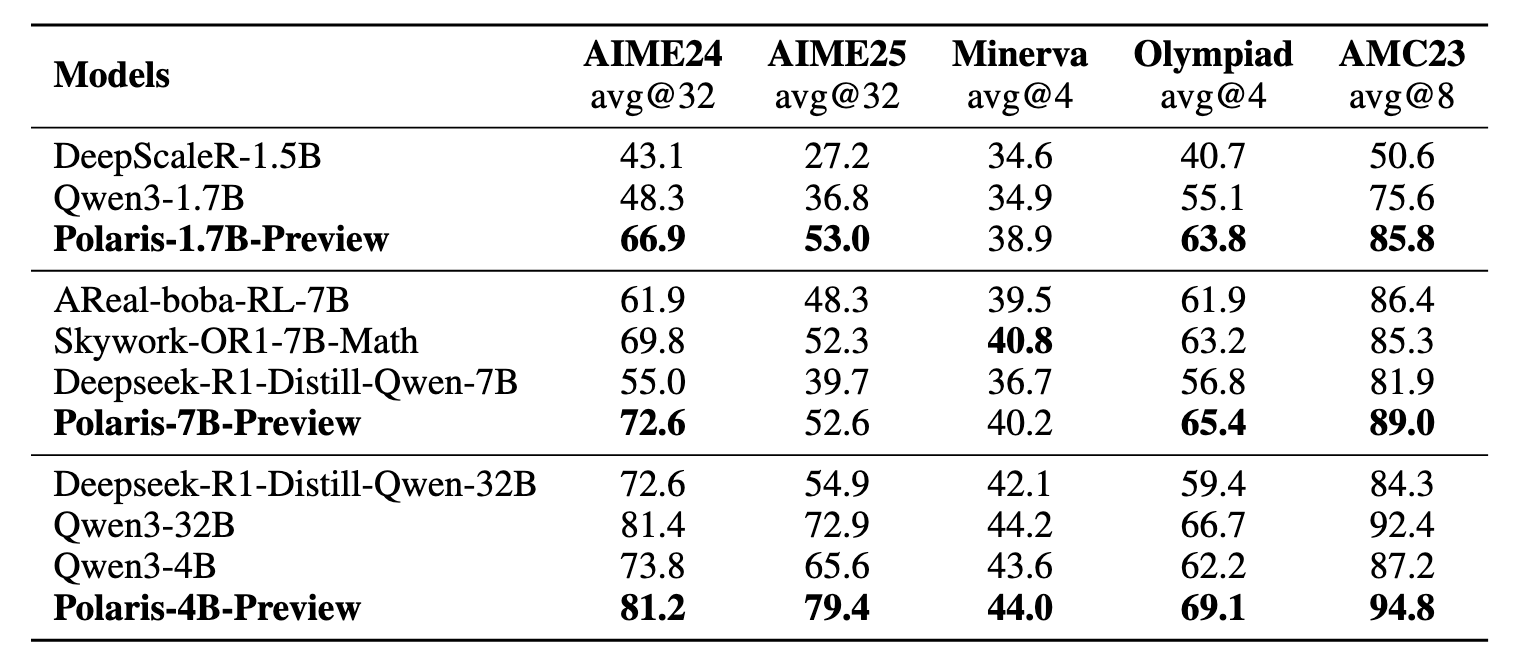

5. POLARIS 训练效果

使用 POLARIS 所提出的方法,团队一共训练了三个模型:Qwen3-1.7B、Deepseek-R1-Distill-Qwen-7B 以及 Qwen3-4B,并在五个主流的推理评测集上验证了算法效果。

结果显示,不同规模的模型以及不同的模型家族,应用 POLARIS 训练方法后,模型效果均有显著提升。尤其在数学标杆评测集 AIME24/25 上,三个模型平均实现 10 分以上提升。目前团队已经开源了 POLARIS 所有训练脚本,具体的训练参数可以参见项目 GitHub 主页。