Seed2.0 正式发布

Seed2.0 正式发布

Date

2026-02-14

Category

Models

大语言模型驱动的产品已深刻融入我们的生活。过去一年多,Seed 开发的 LLM

模型系列已支持豆包等拥有上亿用户的 C 端产品,同时,我们也注意到,随着 Agent

时代到来,LLM

将在现实世界的复杂任务中发挥更大作用:比如参与科学研究,支持复杂软件开发,LLM

甚至可以基于上下文自主学习,完成各类具有经济价值的任务。

在这个关键节点,我们很荣幸地介绍最新 Seed2.0 系列,它们围绕大规模生产环境下的使用需求做了系统性优化,旨在帮助突破真实世界中的复杂任务。

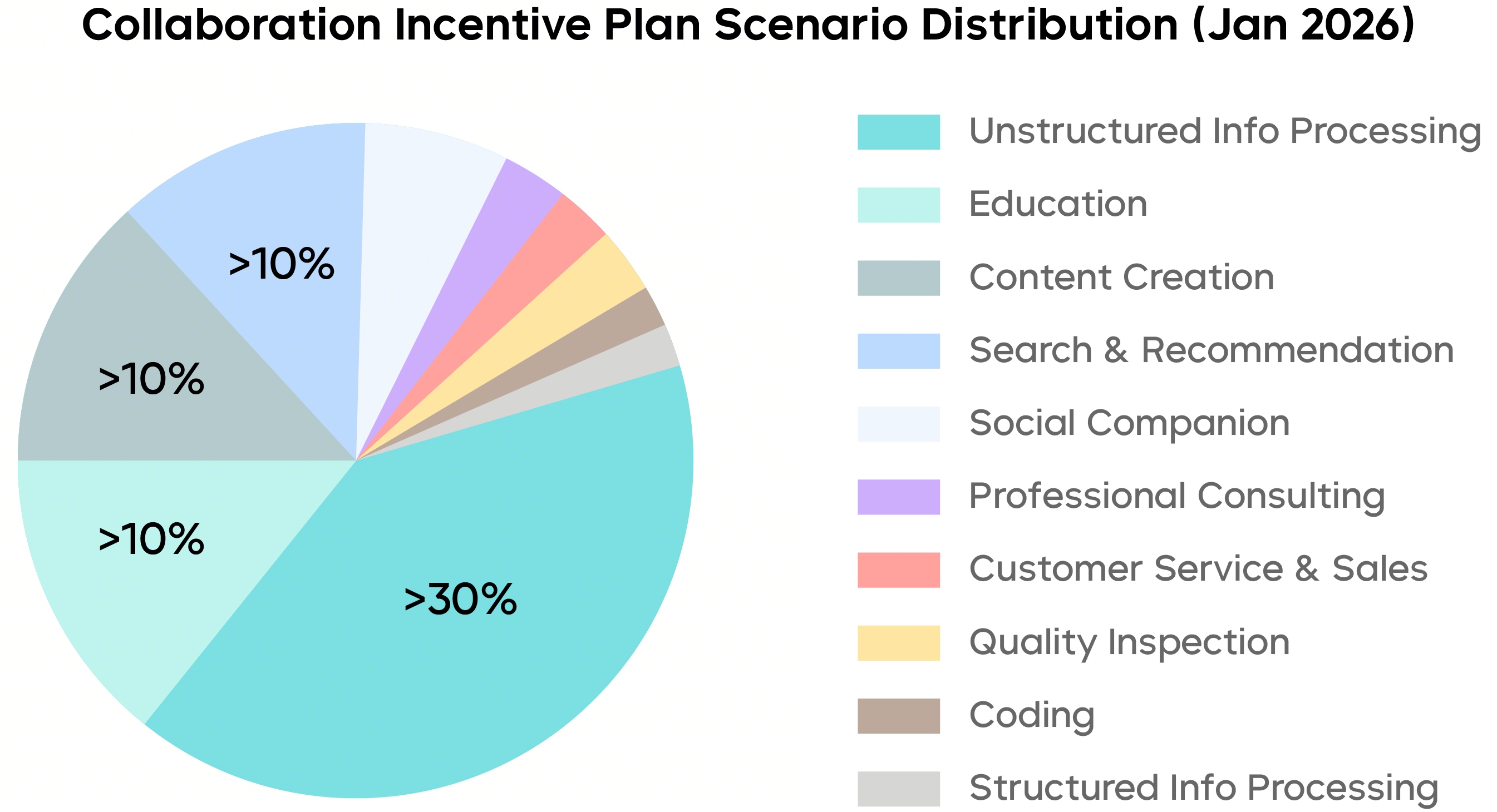

通过分析 Seed 通用模型在 MaaS 服务中的调用情况,我们发现,最高比例的需求为处理混杂图表、文档等非结构化信息的知识内容,企业往往要求模型先做“读得多、想得多”的任务,再进入复杂且专业的流程型工作,对模型的长内容理解和多步任务执行能力要求越来越高。

Seed 通用模型 MaaS 服务在中国陆的调用场景分布,数据来自“火山方舟协作奖励计划”,相关用户已签署授权协议

基于真实使用场景,Seed2.0 系列重点在以下方面进行了优化:

-

更稳健的视觉与多模态理解:Seed2.0 强化了视觉感知与推理能力,对复杂文档、表格、图形、视频内容的解析水平显著提升,视觉信息处理更精准。

-

更可靠的复杂指令执行:Seed2.0 提升了指令遵循和推理表现,并强化了对多约束、多步骤、长链路任务的理解与执行能力,已具备支撑高价值任务的能力基础。

-

更快速、更灵活的推理选择:Seed2.0 提供 Pro、Lite、Mini 三款不同尺寸的通用 Agent 模型,以及专门的 Code 模型,覆盖不同的场景需求,供企业和开发者选择。

除了更好地支持生产级需求,Seed2.0 还致力于提升模型智能上限。目前,Seed2.0 已能从解决奥林匹克竞赛类问题迈向支持研究级的推理任务。比如,Seed2.0 可尝试探索埃尔德什级别的数学问题,也可完成部分科学相关任务的编程工作,进一步突破机器智能的边界。

Seed2.0 Pro 和 Code 模型已分别在豆包 App 和 TRAE 上线,同时,Seed2.0 全系列模型 API 已同步上线火山引擎,欢迎大家体验、反馈。

项目主页(含Model Card):

https://seed.bytedance.com/zh/seed2

体验入口:

1)豆包App-选择“专家”模式-开启对话;

2)TRAE-在“内置模型”中选择“Doubao-Seed-2.0-Code”。

多模态理解能力全面升级

大部分基准达 SOTA 水平

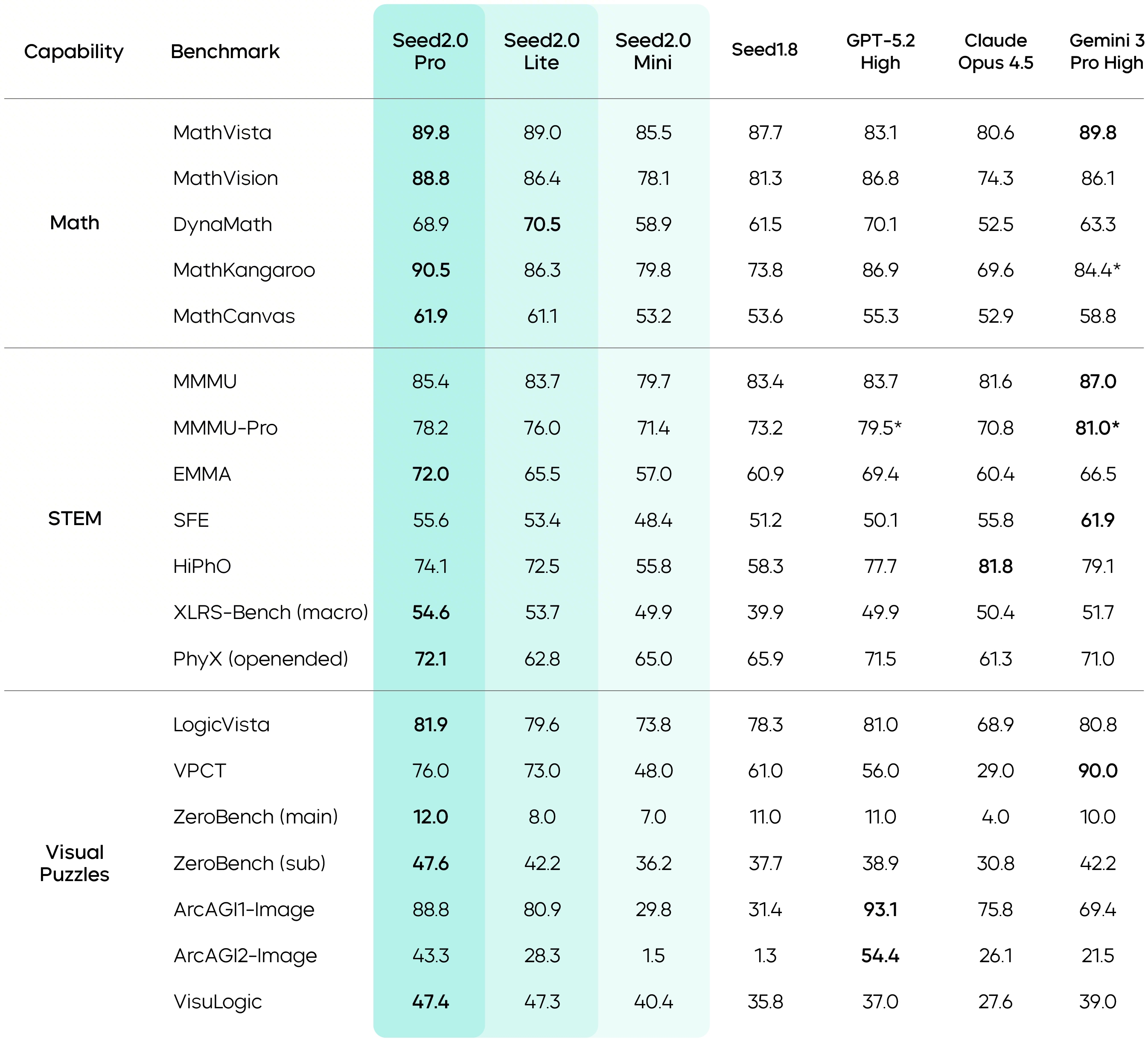

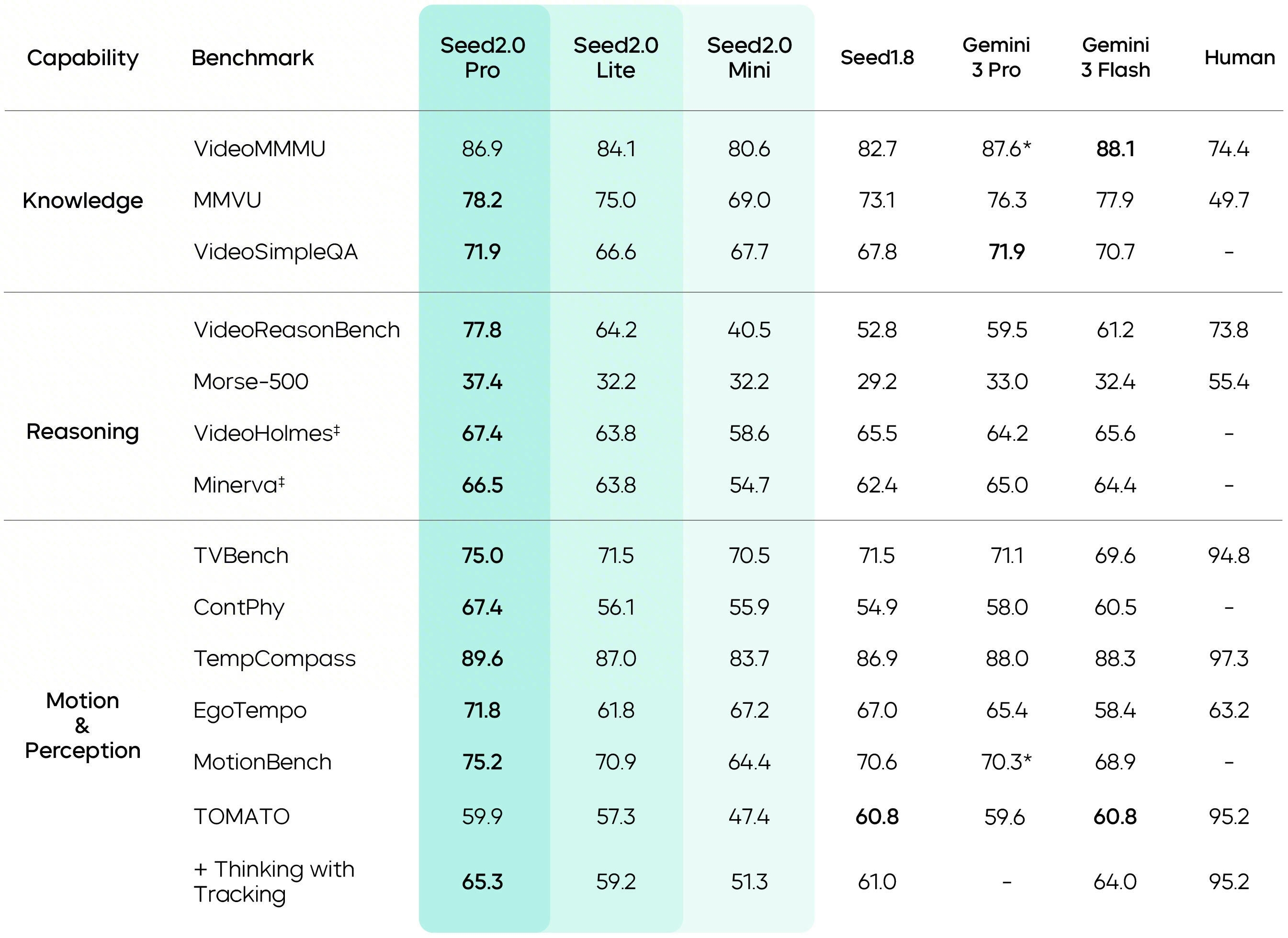

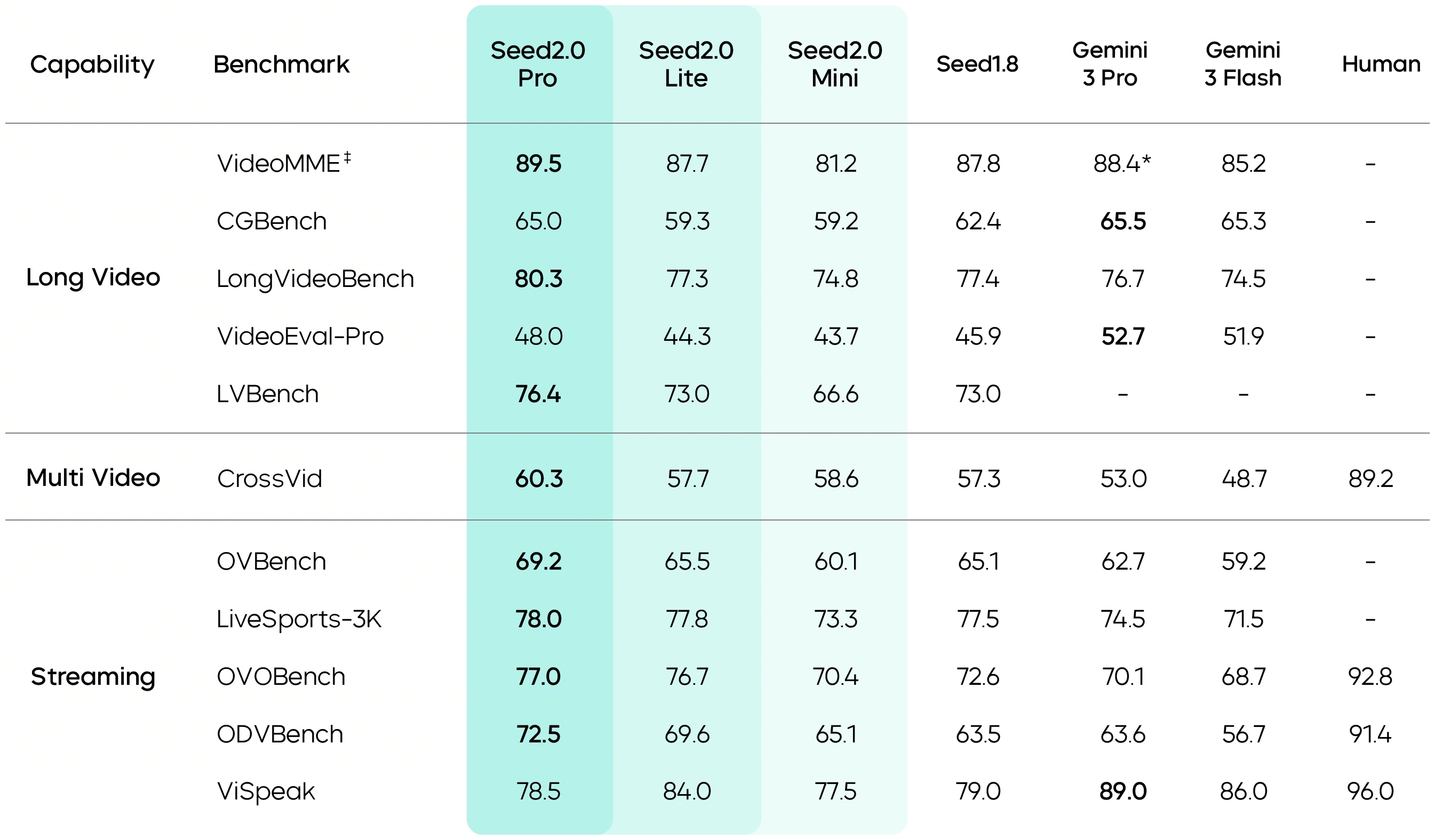

Seed2.0 全面升级了多模态能力,在各类视觉理解任务上均达到业界顶尖水平,其视觉推理、感知能力、空间推理与长上下文理解能力表现尤为突出,Seed2.0 Pro 在大多数相关基准测试中取得了最高分数。

在数学与视觉推理方面,Seed2.0 Pro 在 MathVista、MathVision、MathKangaroo、MathCanvas 等数学推理基准上达到业界最优水平。同时,在 LogicVista、VisuLogic 等视觉解谜与逻辑推理基准上,Seed2.0 Pro 得分较 Seed1.8 显著提升。

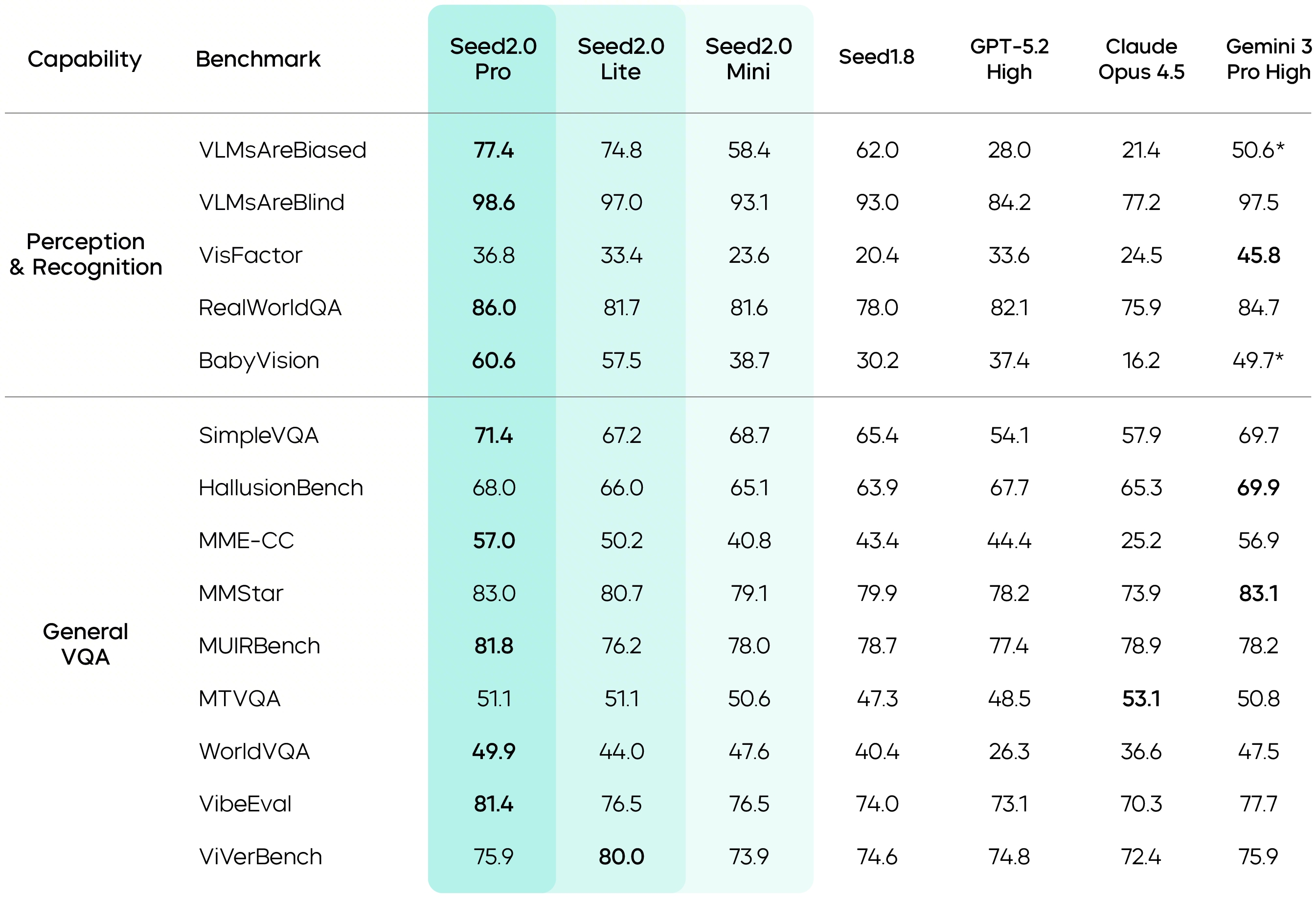

Seed2.0 的视觉感知能力进一步升级。在 VLMsAreBiased、VLMsAreBlind、BabyVision 等基准中,Seed2.0 取得了业界最高分,说明它在面对不同类型的视觉输入时,仍能保持准确且可信的感知和判断能力。

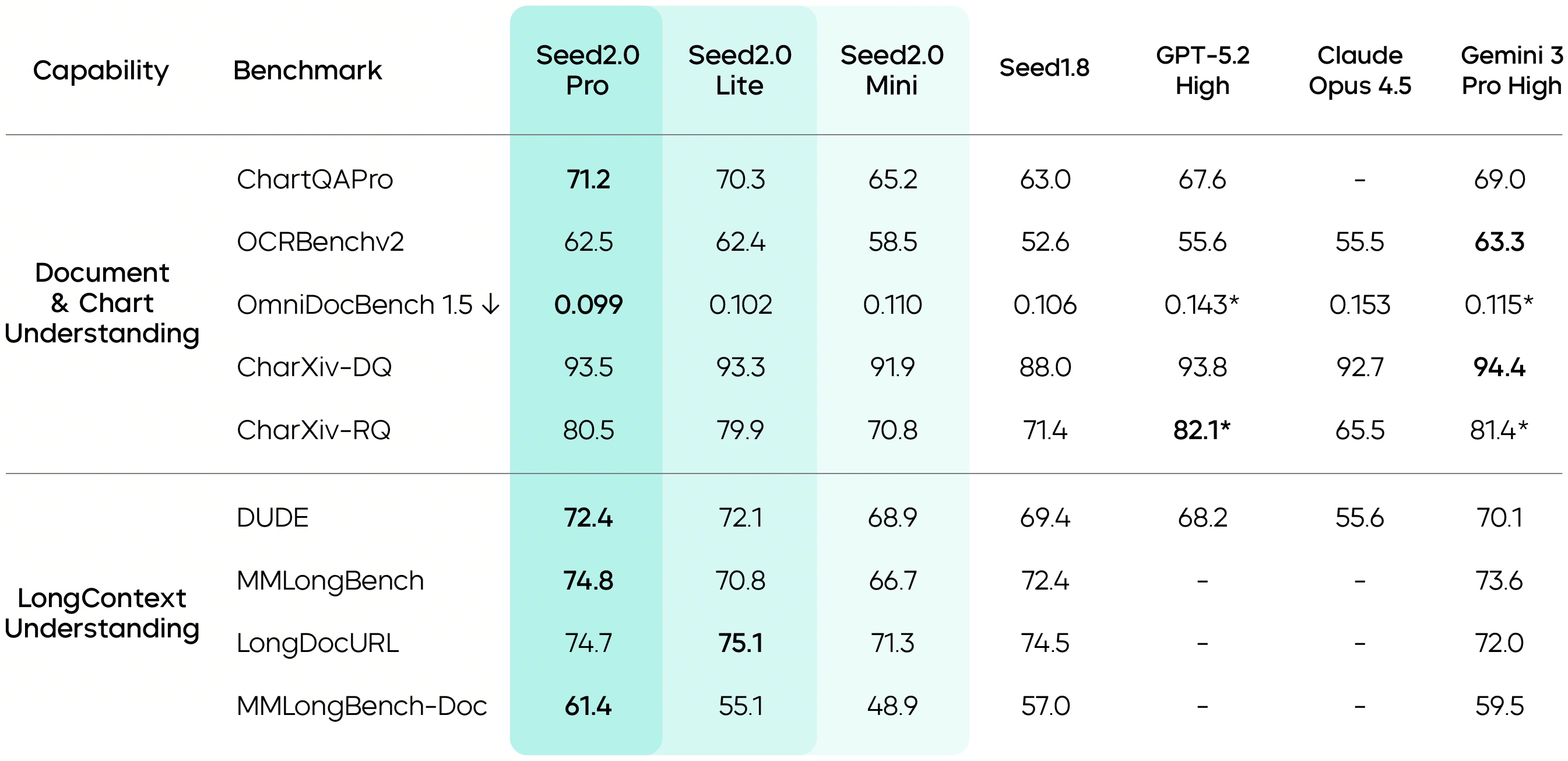

视觉理解基础能力的进步,让 Seed2.0 在真实应用场景中的表现大幅提升。在文档理解中,模型面对的往往不是标准的数据输入,而是复杂版式混排的原始材料。相比 Seed1.8,Seed2.0 处理非结构化信息的能力显著强化,其在 ChartQAPro 与 OmniDocBench 1.5 基准上达到顶尖模型水准。

同时,在长上下文理解方面,Seed2.0 在 DUDE、MMLongBench 与 MMLongBench‑Doc 上均取得业界最佳分数。

面对视频场景,Seed2.0 强化了对时间序列与运动感知的理解能力,在 TVBench、TempCompass、MotionBench 等关键测评中处于领先位置,且在 EgoTempo 基准上超过了人类分数,表明它对“变化、动作、节奏”这类信息的捕捉更为稳定,在工程侧可用性更高。

LLM 与 Agent 表现大幅强化

真实长程任务执行能力提升

Seed 团队观察到一个典型失衡:语言模型已经可以顺利解决竞赛难题,但放在真实世界中,它们依然很难端到端地完成实际任务——比如一次性构建一个设计精良、功能完整的小程序。

LLM 和 Agent 为什么在处理现实问题时屡屡碰壁?我们认为,原因主要来自两点:

-

真实世界任务往往跨越更长时间尺度、包含多个阶段,而现有 LLM Agent 难以自主构建高效工作流,并在长时间跨度中积累经验;

-

真实世界知识具有很强的领域壁垒且呈长尾分布,各行业的经验不在训练语料的高频区,导致即便模型擅长数学与代码,其在专业场景中往往价值有限。

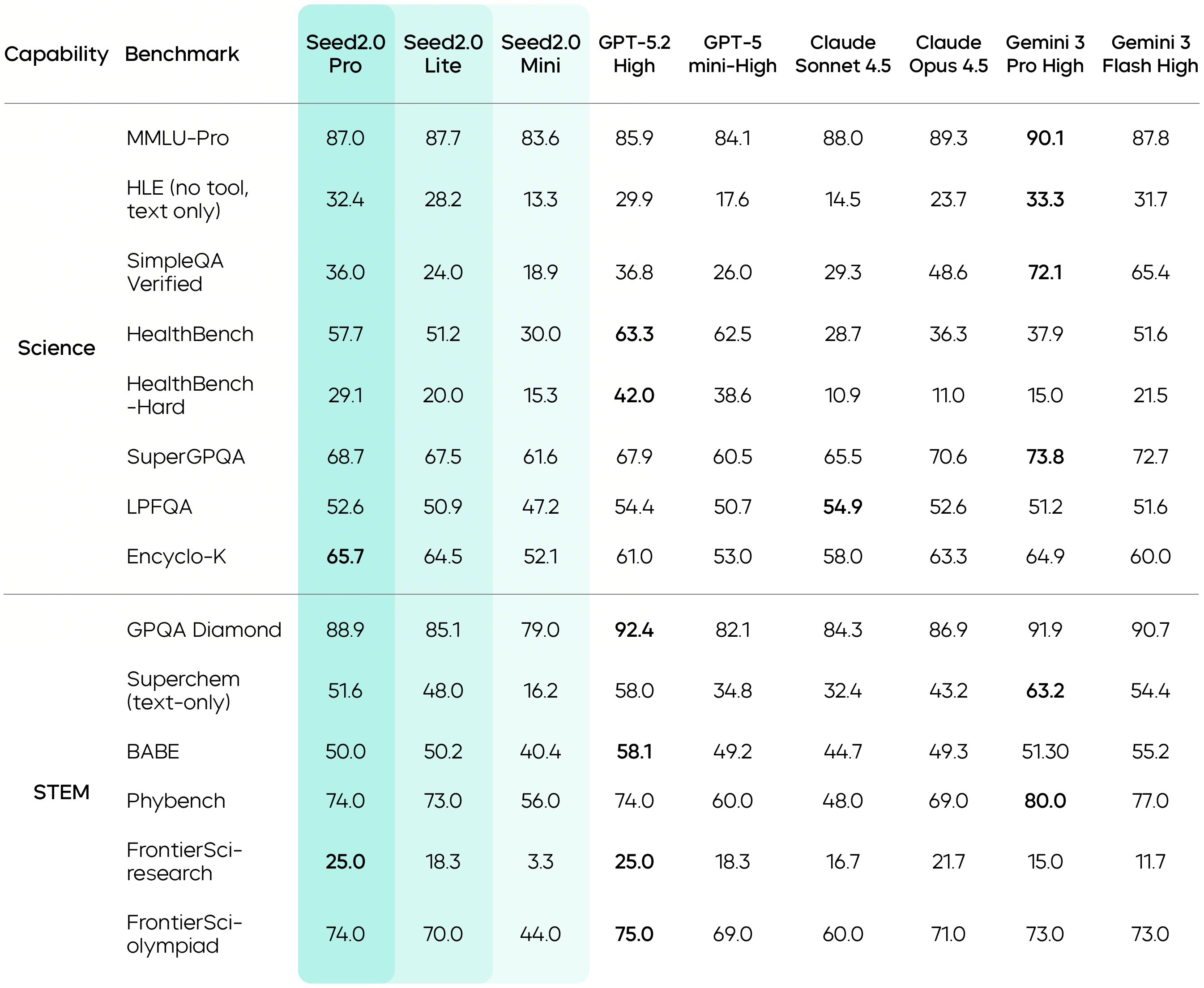

Seed2.0 首先通过系统性加强长尾领域知识来应对这一难题。Seed2.0 Pro 在 SuperGPQA 上分数超过 GPT-5.2,并在 HealthBench 上拿到第一名,其在科学领域的整体成绩与 Gemini 3 Pro 和 GPT-5.2 保持相当水平。

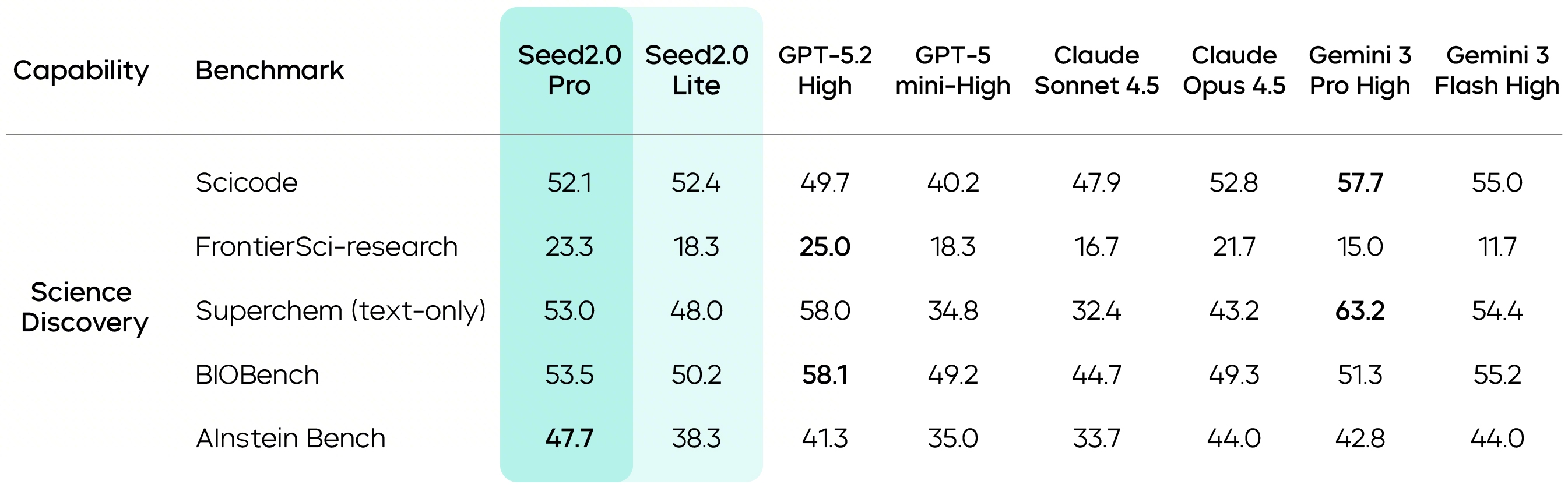

此外,Seed2.0 Pro 在跨学科知识应用上的能力显著增强,其在 FrontierSci 等 STEM 基准测试中表现突出,部分场景得分超过 Gemini 3 Pro。同时,Seed2.0 Pro 在 ICPC、IMO、CMO 测试中均获得金牌成绩,说明模型在数学、代码及推理智能方面进一步提升。

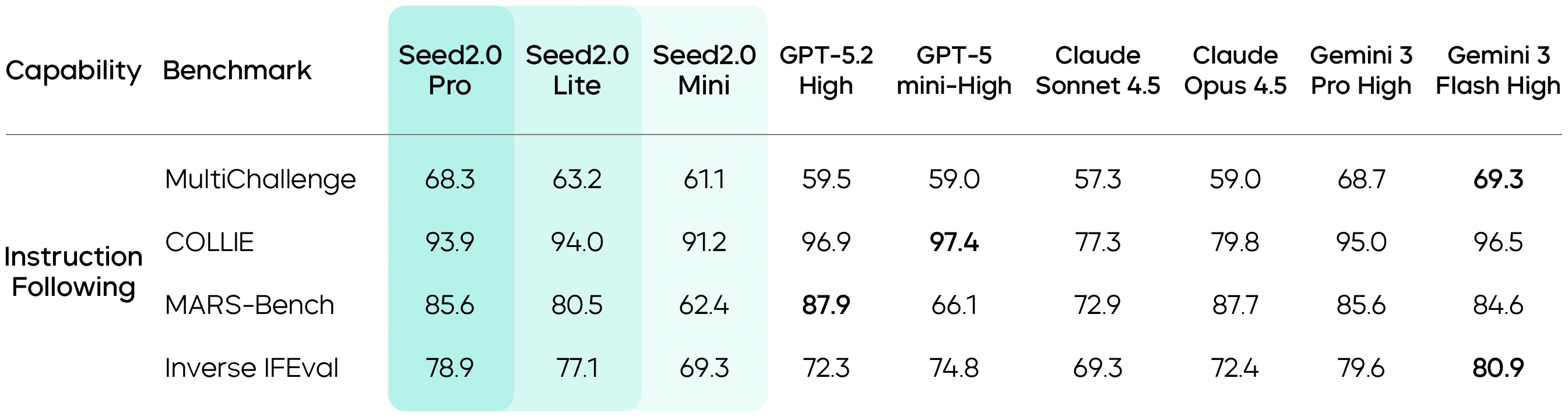

Seed2.0 还重点强化了指令遵循能力。相关评测显示,Seed2.0 可保持较强的一致性与可控性,这为其作为 Agent 模型在长链路、多步骤任务中严格按约束条件执行奠定基础。

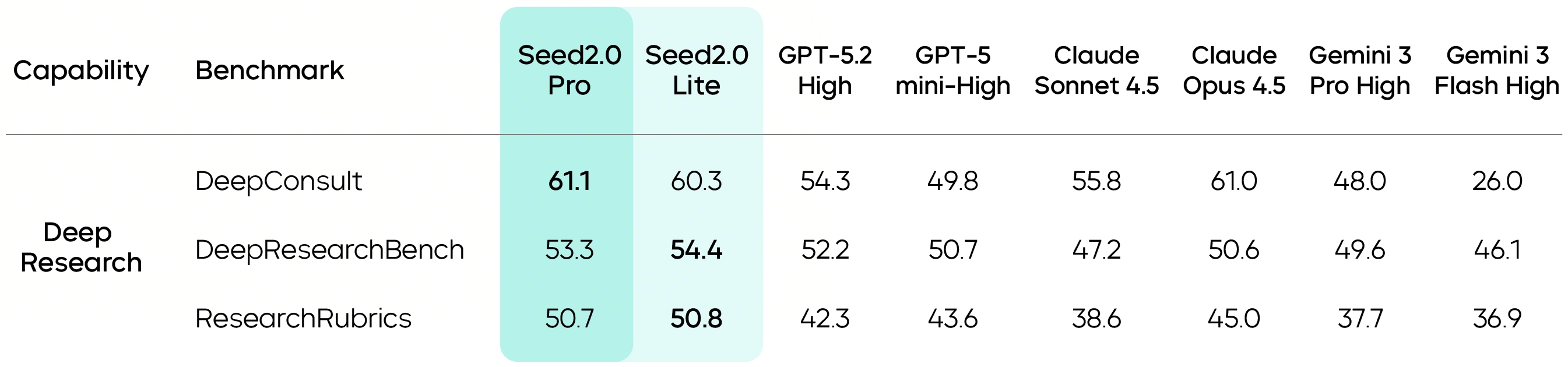

从基础 Agent 能力的得分来看,Seed2.0 在长链路任务中表现突出,尤其擅长连续完成“找资料、做归纳、写结论”等连续工作流。深度研究任务中,Seed2.0 Pro 在相关的三项评测上均取得最高分,展现出在研究型任务里的推进能力与稳定性。

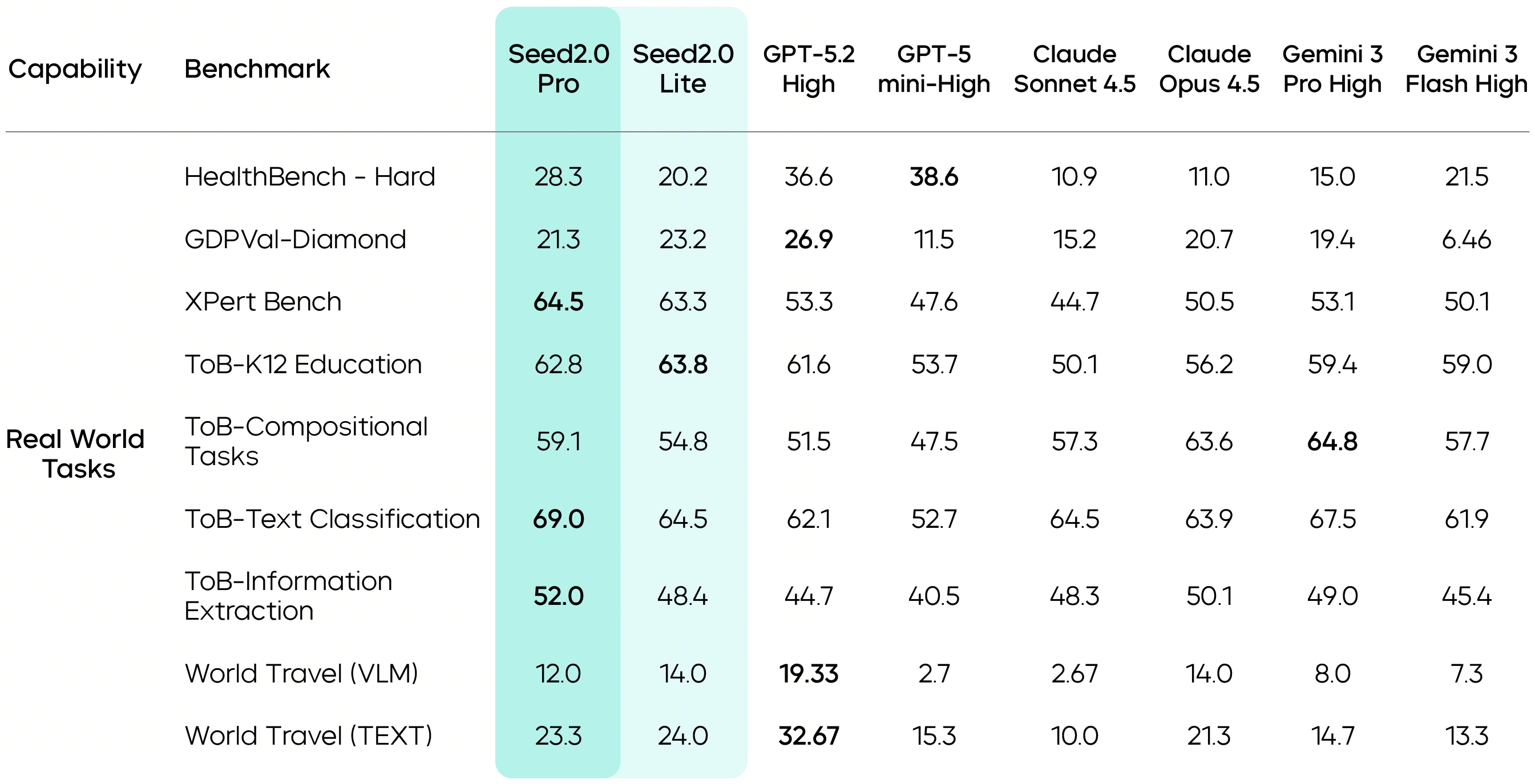

在复杂 Agent 能力评估中,Seed2.0 达到业界第一梯队水平。比如,在具备直接经济价值的现实任务评测中,Seed2.0 在客服问答、信息抽取、意图识别、中小学阶段问题解答等高频用户场景上表现稳定;在 GDPVal-Diamond、XPert Bench 等复杂专业任务基准上,模型同样取得了有竞争力的结果,说明它可以胜任长链路、多约束查询任务。

同时,Seed2.0 Pro 在 FrontierSci‑research 等前沿科研基准上表现强劲,并在 AInstein Bench 上领先,体现出在科学发现场景中较强的假设驱动式推理能力。

此外,Seed2.0 还能把“研究想法”推进到“形成可落地的实验方案”。

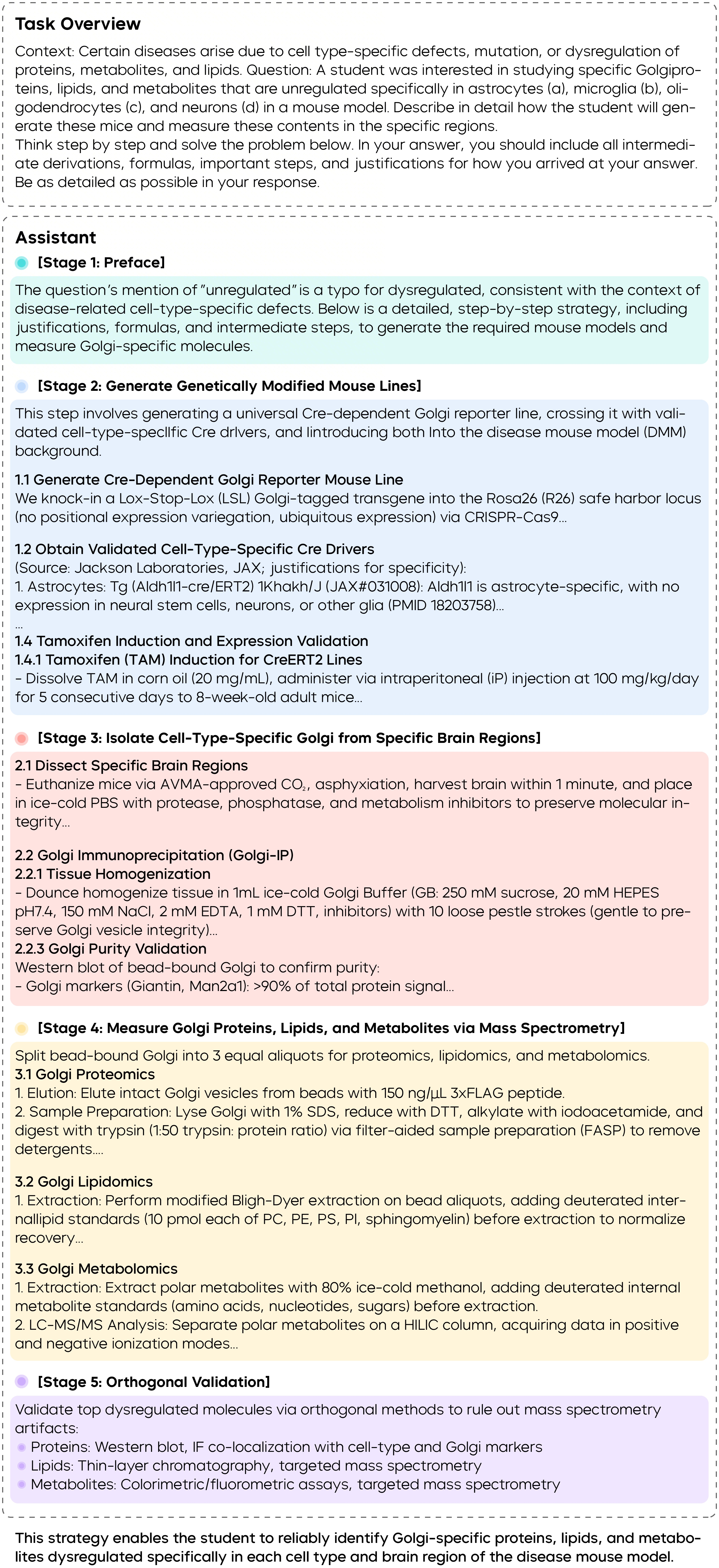

以高尔基体蛋白分析为例,它不仅能给出总体实验路线,还能把基因工程、小鼠模型构建、亚细胞分离与多组学分析串成一条完整流程,细化到关键环节怎么做、用什么进行对照以排除污染、用哪些指标评估纯度。相关领域专家表示,Seed2.0 给出的方案,在跨学科的实验细节与步骤化表达上,超出了他们对大模型的预期,其回答不止停留在策略层面,而是能产出结构清晰、科学上相对可靠,且具有可执行性的实验草案。

在提升了长程任务执行能力的同时,Seed2.0 还进一步降低了推理成本。其模型效果与业界顶尖大模型相当,同时 token 定价降低了约一个数量级。在现实世界的复杂任务中,由于大规模推理与长链路生成将消耗大量 token,这一成本优势将变得更为关键。

*关于评测基准的详细介绍,以及 Seed2.0 的更多真实用例,可以参见模型 Model Card。

总结与展望

针对企业与用户的真实需求及使用场景,我们筛选和搭建了一系列评测基准,用于构建适用于大语言模型的评估体系。

依托这套可靠且具有前瞻性的评估体系,Seed2.0 强化了多模态理解与推理能力,并致力于解决长尾知识与复杂指令遵循问题,从而提升模型在复杂、长周期现实任务中的可靠性。在针对真实应用场景中的评测中,Seed2.0 表现出色,达到业界第一梯队水平,且已表现出支持科学研究级任务的潜力。

同时,我们也观察到,Seed2.0 在端到端整体代码生成、上下文学习方面取得了明显进步,不过在部分高难基准上,其与国际领先模型相比仍有提升空间。未来,我们将继续面向真实场景迭代 Seed 语言模型,不断提高其智能上限。