Seed3D 1.0 发布,一张图生成高精度 3D 模型,纹理生成能力 SOTA

Seed3D 1.0 发布,一张图生成高精度 3D 模型,纹理生成能力 SOTA

日期

2025-10-23

分类

模型发布

世界模拟器对具身智能的发展至关重要,理想情况下可为机器人训练提供复杂的场景模拟和高质量的合成数据,还能支持实时交互的训练环境。

然而,当前技术依然面临瓶颈:基于视频生成的模拟器虽能产生逼真画面,但缺乏物理交互的能力;基于传统图形学的模拟器虽物理交互准确,但生成内容的多样性不够。

今天,字节跳动 Seed 团队推出 3D 生成大模型——Seed3D 1.0,实现从单张图像到高质量仿真级 3D 模型的端到端生成。Seed3D 1.0 基于创新的 Diffusion Transformer 架构,通过大规模数据训练完成,可生成包括精细几何、真实纹理和基于物理渲染(PBR)材质的完整 3D 模型。

Seed3D 1.0 生成的 3D 模型可集成至仿真环境供机器人训练

通过 Seed3D 1.0 生成的 3D 模型能够无缝导入 Isaac Sim 等仿真引擎,仅需少量适配工作即可支持具身智能大模型训练。此外,通过分步的场景生成,Seed3D 1.0 可从单个物体生成,拓展至构建完整的 3D 场景。

Seed3D 1.0 可根据图片生成包含古建筑群的 3D 场景

在与现有 3D 生成模型的对比中,Seed3D 1.0 展现出优势:其纹理与材质生成性能超过此前的开源及闭源模型,几何生成性能超过业界更大参数规模的模型,综合能力达到行业领先水平。

目前 Seed3D 1.0 技术报告已公开,API 也已上线,可访问项目主页查看,欢迎体验和交流。

项目主页:

https://seed.bytedance.com/seed3d

体验入口:

https://console.volcengine.com/ark/region:ark+cn-beijing/experience/vision?modelId=doubao-seed3d-1-0-250928&tab=Gen3D

1. Seed3D 1.0:端到端生成高精度 3D 内容

出于物理准确性的考虑,Seed3D 1.0 选择探索基于图形学路线的世界模拟器,并试图解决该路线下 3D 模型多样性不足、人工制作成本高、周期长的挑战。

在 Seed3D 1.0 研发过程中,团队收集并处理了大规模的高质量 3D 数据,用来训练基于 Diffusion Transformer、易于拓展规模的 3D 生成基础模型。同时,Seed3D 1.0 采用了端到端的技术路线,实现从单张图像到仿真级 3D 模型的快速生成。

Seed3D 1.0 数据构建

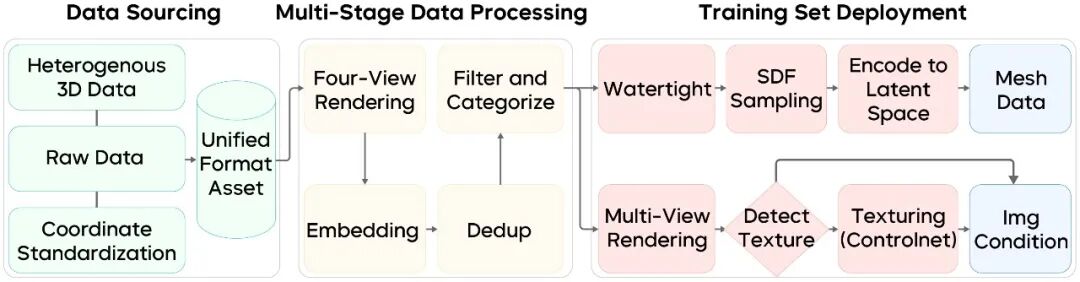

3D 数据的复杂性和多样性是训练中的首要挑战。如下图所示,Seed3D 1.0 构建了完整的三阶段数据处理管线,将海量异构的原始 3D 数据转化为高质量训练集。

处理流程包括三个关键步骤:首先统一原始数据的坐标系和文件格式;然后进行数据去重、姿态转正和类别标注等预处理;最后完成几何表面重构和多视角图片渲染,并生成标准化的训练数据。

团队还开发了高效的分布式数据处理框架,支持大规模数据的存储、索引和可视化,且构建了稳定的训练基础设施,确保大规模扩散模型训练的可靠性。

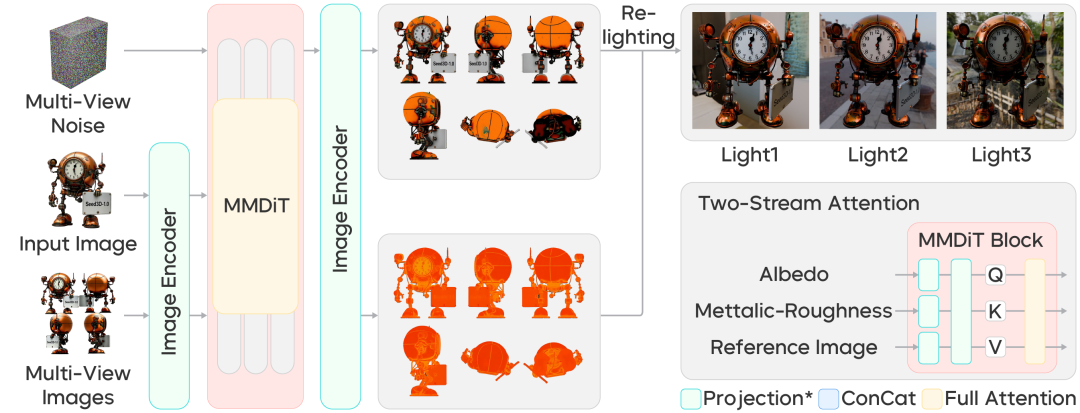

Seed3D 1.0 模型架构

Seed3D 1.0 采用生成式 AI 广泛应用的模型架构 Diffusion Transformer,来设计 3D 几何生成和纹理贴图模型。

-

高精度几何生成

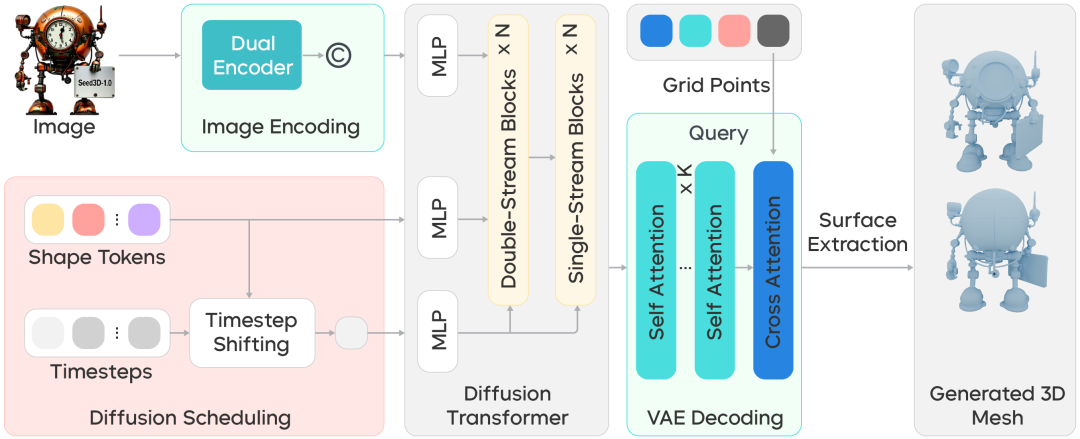

Seed3D 1.0 可以实现对 3D 几何的高精度构建,既能生成精确的结构细节,又能保证封闭曲面、流形几何等形态的物理完整性,以满足仿真计算要求。如下图所示,Seed3D 1.0 在几何生成方面包括两个核心模块:

(1)VAE 编码器:学习 3D 几何的紧凑表征,能高效处理复杂网格结构并保留表面细节。

(2)Diffusion Transformer 模型:在隐变量空间中基于输入图像生成高质量 3D 几何。

这种架构设计既提升了生成效率,又确保了几何的精确性和物理完整性。

-

多视角纹理生成

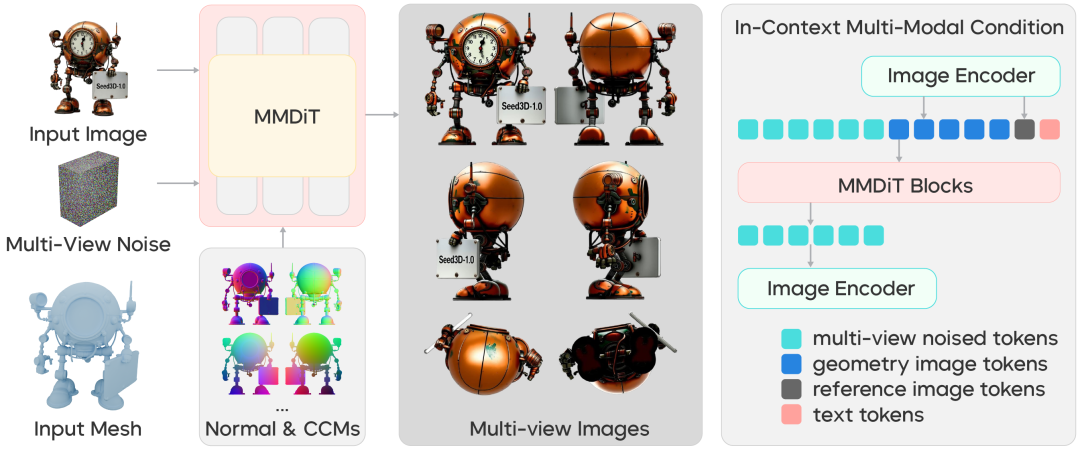

除了精细的几何结构,纹理贴图也是保证 3D 生成视觉效果和多样性的关键。如下图所示,Seed3D 1.0 基于多模态 Diffusion Transformer 架构,构建了多视角图片生成模型。模型输入参考图片和 3D 几何渲染图,输出多视角一致的纹理图像。

其核心创新在于上下文内多模态控制策略和优化的位置编码机制,可确保不同视角间的一致性。针对多视图生成中序列长度增长的挑战,团队采用了偏移时间步采样技术来保证生成质量。

-

PBR 材质生成

高质量材质是实现逼真 3D 渲染的关键。PBR 材质由反射率、金属度和粗糙度三个分量构成,决定了物体的视觉真实性。当前的 PBR 合成方法主要分为两大类:生成式方法通过参考图像和 3D 几何信息合成 PBR 贴图,而直接估计方法从多视图图像中学习分解各项材质分量。受限于高质量 PBR 训练数据的稀缺性,生成式方法的效果往往不如估计式方法真实自然。

基于此考量,Seed3D 1.0 采用估计方法框架。相较于现有方法,团队提出了一种基于 Diffusion Transformer 模型网络的 PBR 生成模型,保证高效生成的同时提升了材质估计的准确性,在数据量有限的情况下具备更强的泛化能力。

如图所示,Seed3D 1.0 直接从多视角图像中学习材质分解,不仅能准确分解出各材质分量,且生成的 PBR 材质在不同光照条件下都能呈现真实的视觉效果。

2. 测评结果:Seed3D 1.0 保持力突出,可准确还原精细特征

为了验证 Seed3D 1.0 的生成质量,团队进行了全面的对比评估,涵盖几何生成和材质纹理生成两大核心任务,通过定量基准测试、定性分析和人工测评多维度评估模型的性能表现。

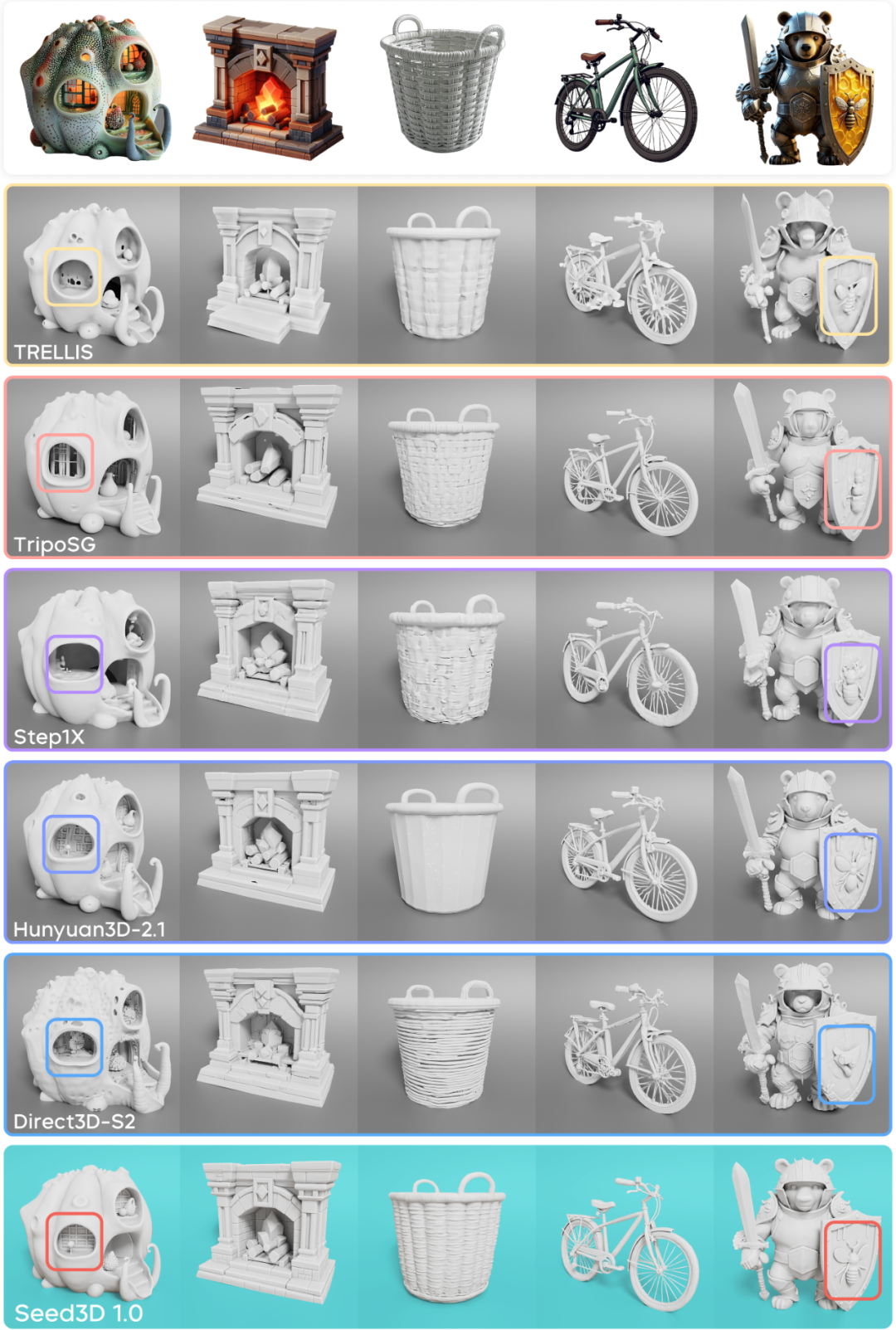

几何生成:参数更少,效果更优

如上图所示,Seed3D 1.0 在细节保持和结构完整性方面优于其他方法,1.5B 参数的 Seed3D 1.0 在性能上超过了业界 3B 参数的模型(Hunyuan3D-2.1),能够更准确地还原复杂物体的精细特征。

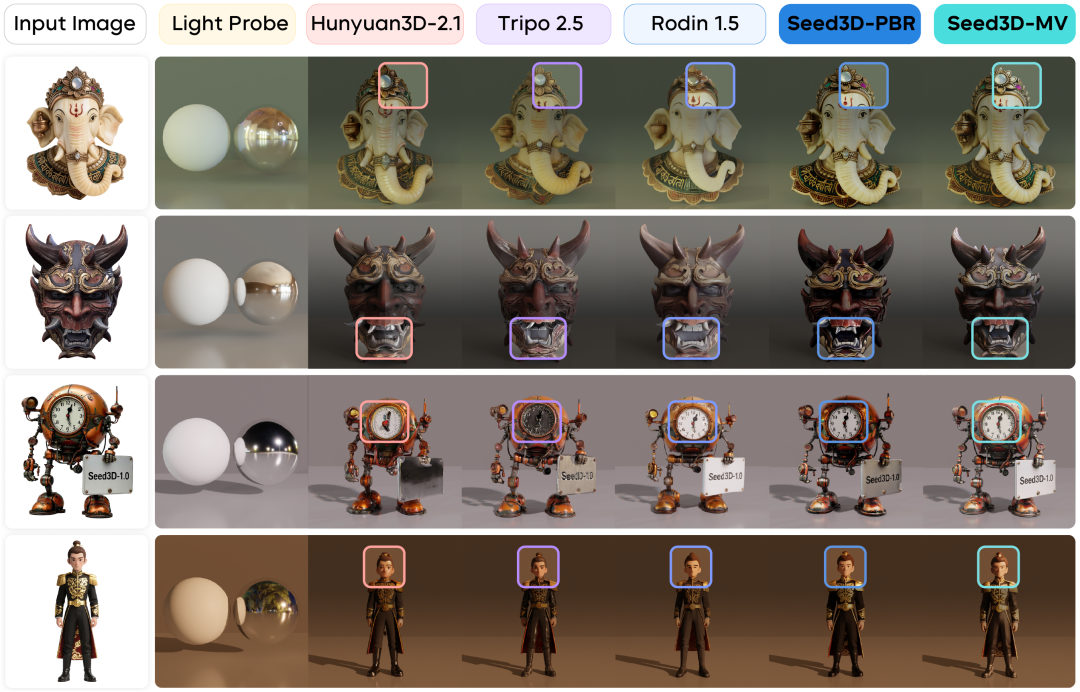

纹理材质生成:图像保持性领先

定性对比直观展现了 Seed3D 1.0 在纹理生成上的优势:它在参考图像保持性方面表现优秀,特别是在精细文本生成上优势明显,以蒸汽朋克时钟为例,当其他模型生成的细节较为模糊时,Seed3D 1.0 依然能保持钟面数字的清晰和机械部件的锐利;在人物生成方面,Seed3D 1.0 能精确还原面部特征和织物纹理,而基线模型普遍保持能力不足;同时,Seed3D 1.0 生成的 PBR 材质表面真实感更强,可实现恰当的金属反射和皮肤次表面散射,在强光照下效果自然。

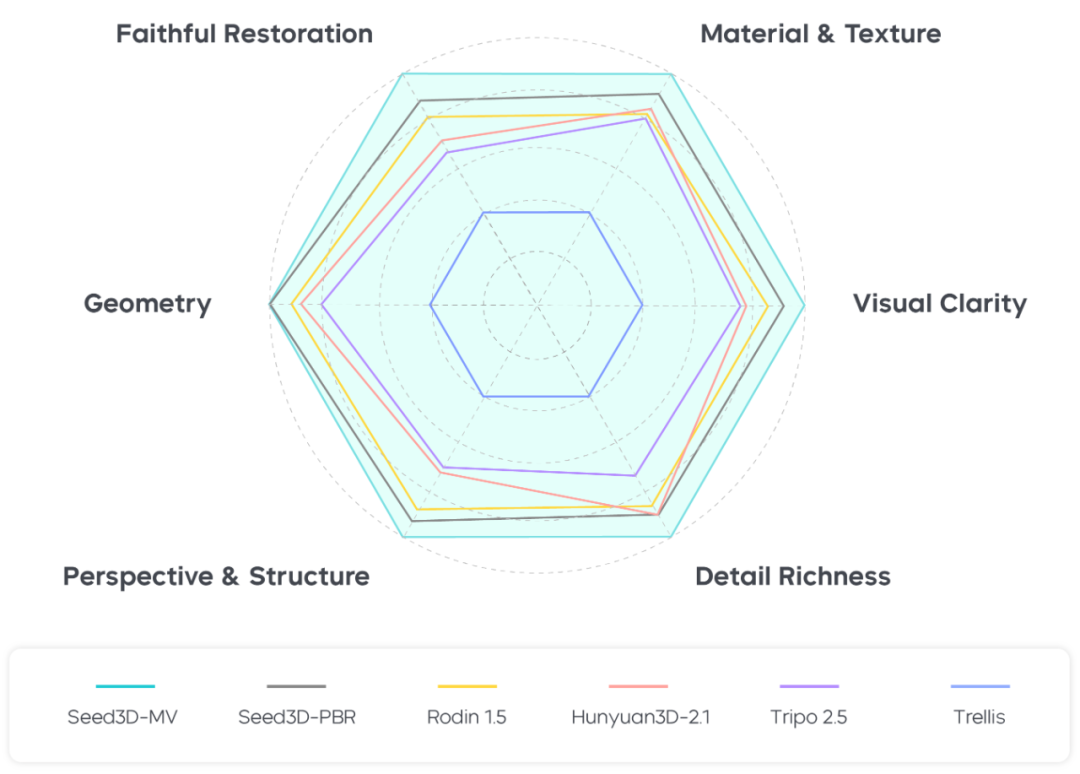

人工评测:几何及材质纹理表现突出

为全面评估生成效果,团队还邀请了 14 名人类评估员,基于 43 张输入图像对不同模型的生成质量进行多维度评估,打分指标包括视觉清晰度、还原度、几何质量、透视与结构、材质与纹理、细节丰富度。结果显示,Seed3D 1.0 在六个维度均获得较好的评分。

在几何生成方面,Seed3D 1.0 在几何质量与透视结构上的表现优于其他基线方法,同时,Seed3D 1.0 的材质纹理表现突出,在输入图片保持、视觉清晰度及细节丰富度上均大幅领先,达到 SOTA 水平。

3. 从单一物体到场景生成,为世界模拟器提供内容支撑

基于 Seed3D 1.0 的高质量生成能力,团队将其拓展到两个关键应用场景:

仿真级 3D 模型生成

如下图所示,输入单张图像,Seed3D 1.0 即可生成能直接集成到 Isaac Sim 中的 3D 模型,用于物理仿真和机器人操作测试。

为了将 3D 模型导入仿真器,Seed3D 1.0 利用视觉语言模型(VLM)估算并调整每个模型的尺度,使其符合真实世界的物理尺寸。Isaac Sim 能够从水密的流形几何体中自动生成碰撞网格,并应用默认的物理属性(如摩擦系数),从而无需手动调优,即可实现即时物理仿真。

团队在 Isaac Sim 中开展了抓取、多物体交互等机器人操作实验,物理引擎可实时返回接触力、物体动力学及操作结果。Seed3D 1.0 生成的模型保留了对真实接触仿真至关重要的精细几何细节,如玩具和电子设备保持了准确的表面特征,供机器人进行抓取规划。

这样的仿真环境为具身智能的开发提供了三大优势:

-

通过多样化的操作场景可大规模生成训练数据;

-

实时反馈机器人动作带来的物理影响,实现交互式学习;

-

提供多视角、多模态的观测数据,为视觉-语言-行动模型构建全面的评估基准。

完整 3D 场景生成

采用分步生成策略,Seed3D 1.0 还可从生成单一物体拓展至生成完整、连贯的 3D 场景。

如下图所示,系统首先利用视觉语言模型从输入图像中提取对象和空间关系的信息,构建场景布局图;然后为每个对象生成相应的 3D 模型;最后根据空间布局将各个物体组装成完整场景。这一框架使 Seed3D 1.0 能够生成丰富的 3D 环境,从办公室空间到城市街景,为世界模拟器提供了场景内容支撑。

4. 总结与展望

尽管 Seed3D 1.0 在三维模型和场景生成中展现了良好性能,团队也意识到,要基于 3D 生成大模型搭建世界模型仍面临生成精度、泛化性需进一步提升等挑战。大规模、自动化的高质量 3D 场景生成,依然处于探索的初期阶段。

未来,团队将尝试引入多模态大语言模型(MLLM)来提升 3D 生成的质量和鲁棒性,并推动 3D 生成模型在世界模拟器中的大规模应用。